مقدمة

اعتبرت شبكة الرواسب [Residual Network (ResNET) [1 من أكثر الأعمال الرائدة في مجال الرؤية الحاسوبية والتعلم العميق في السنوات القليلة الماضية، وذلك بعد النجاح الكبير الذي حققته شبكة AlexNet [2] (وهي شبكة طّي عصبونية CNN عميقة تتألف من ثماني طبقات عصبونية خمسة منها هي طبقات طّي وثلاثة هي طبقات كاملة الاتصال Fully Connected) في مهمة تصنيف مجموعة البيانات الصورية SVRC2012، حيث حافظت الشبكة الراسبة ResNET على الأداء العالي في تدريب مئات وآلاف الطبقات.

ساهمت القدرة التمثيلية القوية لشبكة الرواسب في رفع أداء العديد من تطبيقات الرؤية الحاسوبية مثل التعرف على الوجوه واكتشاف الكائنات مقارنة بالأداء في تطبيقات تصنيف الصور.

اهتمّ الباحثون بأسرار نجاح شبكة الرواسب منذ عام 2015، وأجريت العديد من التحسينات على البنية المعمارية للشبكة.

تقسم هذه المقالة إلى جزئين، يُقدم الجزء الأول بعض المعلومات الأساسية عن شبكة الرواسب، و يعرض الجزء الثاني أبحاثاً عن التغيرات المختلفة التي طرأت على البنية المعمارية للشبكة وتفسيرها.

المحتويات

1-شبكة الرواسب المُنقّحة

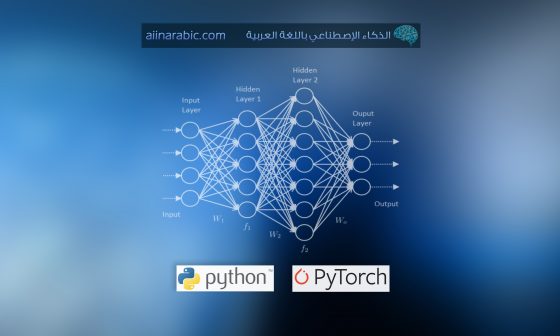

وفق نظرية التقريب الشامل universal approximation theorem فإن الشبكة العصبونية ذات الانتشار الأمامي feed forward network بطبقة خفية واحدة Hidden Layer وبعدد محدد من العصبونات الخفية تكون كافية لتمثيل أي وظيفة خطية. إلا أن هذه الطبقة الخفية قد تكون ضخمة ويكون عدد بارمترات الشبكة كبير جداً فيرتبط تعليم الشبكة بمجموعة محددة من البيانات، ويصبح من الصعب تعليم الشبكة دون مواجهة مشكلة طفحان الملاءمة overfitting. لذلك يتم التوجه بحثياً لتعميق البنية المعمارية للشبكة.

اعتباراً من الشبكة AlexNet أصبحت بنية شبكات الطي CNN الحديثة تميل لأن تكون أكثر عمقاً، فبينما احتوت شبكة AlexNet على 5 طبقات طي فإن الشبكة [VGG [3 احتوت 19 طبقة طّي واحتوت شبكة GoogleNet [4] التي يطلق عليها تسمية Inception_v1 على 22 طبقة.

لا يزداد عمق الشبكة ببساطة عن طريق تكديس الطبقات معاً، كما أنّ الشبكات العميقة من الصعب تدريبها بسبب ظهور مشكلة “تلاشي المُشتق تدريجياً حتى الانعدام” vanishing gradient الشهيرة، حيث يعاد انتشار قيمة المشتق خلفاً إلى الطبقات الأولى بالضرب المتكرر وبالتالي تصبح قيمة المشتق لا متناهية في الصغر، وكنتيجة لذلك كلما كانت الشبكة أكثر عمقاً يصل الأداء لحد الإشباع أو يسوء بشكل سريع.

كان هناك عدة طرق لمعالجة مشكلة تلاشي المشتق حتى الانعدام قبل ظهور شبكة الرواسب ولم تستطع أي منها معالجة المشكلة بشكل فعلي، ومن هذه الطرق على سبيل المثال في [4]، إضافة خسارة loss مساعدة في الطبقة الوسطى لتعمل كمراقب إضافي في الشبكة.

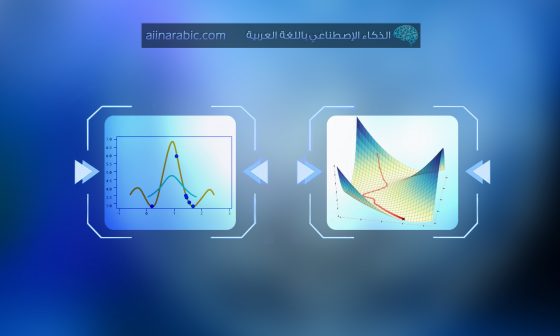

تمّ حساب خطأ التدريب وخطأ الفحص على مجموعة بيانات CIFAR-10 على 20 طبقة و56 طبقة وكان خطأ التدريب والاختبار في الشبكة العميقة كما هو واضح في الشكل (1).

الفكرة الأساسية لشبكة الرواسب هي إضافة ما يسمى “معرف وصلة الاختصار” identity shortcut connection الذي يتجاوز طبقة أو أكثر كما هو موضح في الشكل التالي المعبر عن كتلة الراسب a residual block:

أي أن انتشار الإشارة في كتل البناء في شبكة الرواسب أماماً وخلفاً يتم من كتلة بناء إلى أي كتلة أخرى، وبالتالي عند استخدام مفهوم معرف التخطّيط identity mapping كوصلات تجاوز لبعض الكتل تتضح أهمية معرف التخطّيطات في تسهيل التدريب [7].

يُعرَف مفهوم معرف التخطّيطات جبرياً بالعلاقة h(xl) = xl التي تدل أن معرف التخطّيطات (التابع ) h يعطّي قيمة في الخرج مساوية لقيمة الدخل.

وبالتالي فإن هذا المفهوم في سياق الشبكات العصبونية يدل على أن خرج بعض الشبكات العصبونية متعددة الطبقات من الممكن أن يكون مساوياً لدخلها، وعلى الرغم من أنه لا فائدة في ذلك إلا أنه يمكن استخدام مفهوم معرف التخطّيط للتأكيد على إمكانية الحصول على نظام ما (بنية أو كتلة أو بيئة) بإعادة استخدام نظام قديم، وبالتالي اعتباره كطبقة لا تقوم بأي عمل.

يعتقد الباحثون في [1] أن تكديس الطبقات يجب أن لا يُنقص أداء الشبكة لأنه من الممكن تكديس معرف التخطّيطات على الشبكة الحالية، والبنية الناتجة ستعطّي نفس الأداء. هذا يشير إلى أن النموذج الأعمق يجب أن لا يعطّي خطأ تدريب أكبر من نظيره البسيط. كما و يفترض الباحثون أن جعل الطبقات المتكدسة تلاءم تخطّيط الرواسب أسهل من جعلها تلائم بشكل مباشر التخطّيط الأساسي المطلوب. يبين الشكل (2) وحدة الراسب التي تسمح بذلك، حيث وُجِدَ معرف التخطّيط لإضافة الخرج من الطبقة السابقة إلى الطبقة التالية فقط وليس له أية معاملات.

في الواقع لم تكن شبكة الرواسب هي الشبكة الأولى التي استفادت من وصلات الاختصار، بل إنّ شبكة الطريق السريع [5] Highway (شبكات الطريق السريع هي بنية جديدة من الشبكات تسمح بتدفق المعلومات عبر مئات الطبقات دون عوائق من خلال الاستفادة من فكرة التحكم في تدفق المعلومات عبر هذه الطبقات وذلك بهدف التغلب على مشكلة التدريب عندما يزداد عمق الشبكة) أضافت وصلات اختصار ذات بوابات، وتتحكم البوابات ذات المعاملات بمقدار المعلومات المسموح مرورها عبر الاختصار.

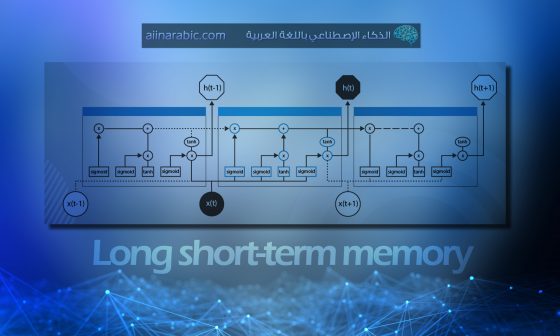

توجد فكرة مشابهة في الشبكة الإرجاعية ذات الذاكرة قصيرة وطويلة الأمد Long Term Short Memory (LSTM) [6] حيث تحتوي شبكة LSTM على وحدات تحكم تسمى البوابات مهمتها تنظيم تدفق المعلومات مثل بوابة النسيان forget gate ذات المعاملات التي تتحكم بمقدار المعلومات التي ستمر إلى الخطوة الزمنية التالية في التسلسل الزمني المدروس، وبالتالي يمكن اعتبار شبكة الرواسب كحالة خاصة من شبكة الطريق السريع Highway.

بكل الأحوال تبين التجارب أن شبكة Highway لم تتغلب بالأداء على شبكة الرواسب وهذا الأمر غريب لأن فضاء الحلول لشبكة Highway يشمل فضاء الحلول لشبكة الرواسب فعلى الأقل يجب أن يكون أداء Highway جيداً مثل شبكة الرواسب. والاقتراح أنه من المهم جداً المحافظة على highway متدرجة واضحة أكثر من الذهاب إلى فضاء حلول أكبر.

قام الباحثون في [1] بتحسين كتلة الرواسب واقترحوا متغير قبل التفعيل pre-activation variant لكتلة الرواسب [7]، بحيث يمكن لقيمة المشتق أن تمر عبر وصلات الاختصار إلى أي طبقة سابقة بدون عوائق. في الواقع باستخدام كتلة الرواسب الأصلية في [1], تدريب شبكة الرواسب ذات 1202 طبقة أعطى أداء أسوأ من تدريب نظرائها بـ 110 طبقات.

يبين الجدول التالي النسبة المئوية لخطأ التصنيف على مجموعة بيانات الاختبار CIFAR-10 باستخدام توابع تفعيل مختلفة.

| الحالة/تابع التفعيل | الشكل | ResNet-110 | ResNet-164 |

| Original Residual Unit [1] | Fig. 4(a) | 6.61 | 5.93 |

| BN after addition | Fig. 4(b) | 8.17 | 6.50 |

| ReLU before addition | Fig. 4(c) | 7.84 | 6.14 |

| ReLU-only pre-activation | Fig. 4(d) | 6.71 | 5.91 |

| Full pre-activation | Fig. 4(e) | 6.37 | 5.46 |

جدول (1): استخدامات مختلفة لتابع التفعيل في شبكة الرواسب العميقة

يبين الشكل (4) استخدامات مختلفة لتابع تفعيل شبكة الرواسب الموضح بالجدول السابق. جميع الوحدات متشابهة بالمكونات ولكن مختلفة في الترتيب.

2-تغيرات شبكة الرواسب العميقة الأخيرة وتفسيراتها

دُرِسًّت بنية شبكة الرواسب بشكل مُعمق مع ازدياد شعبيتها في المجال البحثي. سنقدم في هذا المقطع بنى عديدة لشبكات تعتمد على شبكة الرواسب، ونعرض مقالة توضح تفسير استخدام شبكة الرواسب كمجموعة من الشبكات الأصغر.

1-2-شبكة ResNeXt

اقترح الباحث Saining Xie ورفاقه في [8] شبكة رواسب مختلفة يرمز لها ResNeXt لها كتلة البناء الموضح بالشكل(5- a) حيث عدد المسارات في كتلة البناء لشبكة ResNeXt تساوي 32، ولها نفس درجة التعقيد مقارنة مع كتلة البناء لشبكة الرواسب الموضحة في الشكل (b-5). يتم عرض الطبقة في الشكل من خلال توضيح قنوات الدخل وقنوات الخرج وحجم المرشح.

تبدو كتلة البناء في شبكة ResNeXt مألوفة لأنها تشبه نموذج جوجل-انسبشن Inception module في البحث [4] والموضح في الشكل (6)، فكلاهما يتبع نفس طريقة التقسيم – النقل – الدمج، إلا أنه في هذا النوع من الشبكة يتم دمج خرج المسارات المختلفة بإضافتها إلى بعضها البعض بينما في نموذج جوجل-انسبشن تكون المسارات متصلة في العمق.

يوجد اختلاف آخر في نموذج جوجل-انسبشن Inception module في [4] وهو أن المسارات تكون مختلفة عن بعضها البعض فتكون ببنية (1×1, 3×3 و 5×5) طبقة طّي بينما في هذا النوع من الشبكة تكون المسارات بنفس الهيكلية في كل مسار.

قدم الباحثون في [4] معامل (متغير) قابل للضبط (hyper-parameter) يسمى بعدد العناصر cardinality وهو عدد المسارات المستقلة والذي يؤمن طريقة جديدة في ضبط سعة النموذج، حيث أثبتت التجارب أن الدقة تزداد بزيادة قيمة هذا البارامتر أكثر مما تزداد بالذهاب عمقاً أو عرضاَ في الشبكة. كما عرضوا مقارنة بنية هذا النوع من الشبكة مع نموذج جوجل-انسبشن Inception module فكانت البنية الحالية أسهل في التكيف مع المعطّيات والمهام الجديدة لأنها ذات نموذج بسيط ولها بارامتر واحد فقط يحتاج الضبط بينما في بنية نموذج جوجل-انسبشن فيوجد عدة بارمترات تحتاج للضبط كحجم مرشح الطّي لطبقة الطّي من أجل كل مسار.

يوجد ثلاثة أشكال متكافئة لكتلة البناء في هذا النوع الجديد من الشبكة كما هو موضح في الشكل (7):

عملياً، تتم عملية “التقسيم والنقل والدمج” بتجميع نقطّي لخرج طبقة الطّي التي تم تقسيم دخلها إلى مجموعات من خرائط الصفات ثم إجراء عملية الطّي مع اعتبار أن المخارج متصلة بالعمق ثم تقديم الخرج الناتج من التجميع النقطّي كدخل لطبقة طّي بحجم 1×1.

2-2-شبكة الطّي العصبونية الكثيفة Densely Connected CNN

اقترح هوانغ ورفاقه في [9] بنية جديدة تسمى الشبكة الكثيفة DenseNet التي تستخدم تأثيرات اتصالات الاختصار فهي تصل بشكل مباشر جميع الطبقات مع بعضها البعض. في هذه البنية الجديدة يتألف دخل كل طبقة من خرائط الصفات لكل الطبقات السابقة ويمرر الخرج إلى كل طبقة تالية ويتم تجميع خرائط الصفات وفق تسلسل العمق.

يناقش الباحثون في [9] أن هذه البنية الجديدة تشجع إعادة استخدام الصفات مما يجعل الشبكة ذات كفاءة عالية بالنسبة للمتغيرات وذلك على عكس مشكلة تناقص قيمة المشتق حتى الانعدام. أحد تفسيرات هذه الخاصية للبنية الجديدة كما هو موضح في [1][7] هو أن خرج معرف التخطّيط أضيف إلى الكتلة التالية مما يعيق تدفق المعلومات إذا كانت خرائط الصفات للطبقتين ذات توزع مختلف وبالتالي فإن خرائط المزايا المتسلسلة يمكن أن تحافظ على جميع المعلومات وتزيد من تباين الخرج مشجعة بذلك إعادة استخدام المزايا.

تحتوي الطبقة الأولى على k * (l-1) + k_0 خارطة صفات كدخل حيث k_0 هي عدد الأقنية في صورة الدخل. استخدم المؤلفون معامل متغير k يدل على معدل النمو growth rate (k) لمنع الشبكة من النمو بشكل كبير كما استخدموا طبقة طّي بحجم 1×1 كطبقة عنق زجاجة لتقليل عدد خرائط الصفات قبل طبقة الطّي المكلفة ذات البعد 3×3 وبالتالي فإن البنية العامة موضحة في الجدول (2) التالي حيث معدل النمو من أجل الشبكات الثلاثة الأولى k=32 ومن أجل شبكة DenseNet-161 هو k=48 .

3-2-الشبكة العميقة ذات العمق العشوائي

على الرغم من أنّ شبكة الرواسب أثبتت قوتها في عدة تطبيقات إلا أنّ أحد العوائق الرئيسية هو أنّ الشبكة العميقة عادة تتطلب عدة أسابيع لتدريبها، مما يجعلها غير قابلة للتطبيق عملياً في العالم الواقعي.

قدّم الباحث هوانغ ورفاقه في [10] حلاً لهذه المشكلة بطريقة غير بديهية عن طريق حذف طبقات عشوائياً أثناء التدريب. واستخدام كامل الشبكة أثناء الاختبار.

استخدم الباحثون في حلهم الكتلة الراسبة باعتبارها البنية الأساسية في بنية الشبكة، لذلك أثناء التدريب عندما تُفعّل كتلة راسبة ما فإنّ دخلها ينتقل إلى كل من معرف الاختصار identity shortcut وطبقات الأوزان وإلا فإن الدخل ينتقل فقط إلى معرف الاختصار. في زمن التدريب، يكون لكل طبقة احتمالية بقاء “survival probability” وتُحذَف عشوائياً، أما في زمن الاختبار، فإن كل الكتل تبقى فعّالة وقابلة لإعادة المعايرة حسب احتمال بقائها أثناء التدريب.

كصيغة رسمية، باعتبار Hl هي خرج الكتلة الراسبة lth ،fl تعبر عن التخطّيط المعرّف بتخطّيط أوزان الكتل lth ، أما bl فهي متحول برونولي (Bernoulli) العشوائي الذي يمكن أن يكون 1 أو 0 (ليدل على حالة تفعيل الكتلة) خلال التدريب.

عندما تكون قيمة bl مساوية لقيمة 1 فإن هذه الكتلة تصبح كتلة راسبة عادية، وعندما تكون بقيمة 0 فإن المعادلة السابقة تصبح بالشكل التالي:

بما أن Hl-1 هي خرج تابع التفعيل Relu وهو يحمل قيمة غير سالبة، فإنّ المعادلة في الأعلى يتم اختصارها إلى معرف الطبقة الذي يقوم فقط بتمرير الدخل إلى الطبقة التالية:

إن bl يعبر عن احتمالية البقاء للطبقة l خلال التدريب، وبالتالي تصبح المعادلة أثناء الاختبار كما يلي:

طبّق المؤلفون قاعدة التضاؤل الخطّي “a linear decay rule” على احتمالية البقاء لكل طبقة. حيث ناقشوا بأنه طالما أنّ الطبقات الأولى تستخرج خصائص منخفضة المستوى والتي ستستخدم في الطبقات اللاحقة، فلا يجب حذفها مرات كثيرة، وبالتالي تصبح القاعدة العامة:

حيث تعبر L عن العدد الكلي للكتل ، بينما تعبر pL عن احتمالية البقاء لآخر كتلة راسبة، وتم تثبيت قيمتها إلى 0.5 خلال التجارب.

لاحظ أنه يتم التعامل مع الدخل على أنه الطبقة الأولى (l = 0) وبالتالي لايحذف إطلاقاً.

يوضح الشكل التالي الإطار العام للتدريب العميق المبني على العشوائية.

بشكل مشابه لتقنية تعطيل عمل بعض العصبونات Dropout [11]، يمكن أن يكون تدريب الشبكة العميقة ذات العمق العشوائي كتدريب عدة شبكات رواسب صغيرة، إلا أنّ الفرق هو أن هذه الطريقة تحذف الطبقة بأكملها عشوائياً بينما في تقنية تعطيل عمل بعض العصبونات تحذف فقط جزء من العصبونات الخفية لطبقة واحدة أثناء التدريب.

تظهر التجارب أن نتائج تدريب شبكة رواسب ذات 110 طبقة ذات عمق عشوائي أفضل في الأداء من تدريب شبكة رواسب ذات 110 طبقة وعمق ثابت، بينما يكون زمن التدريب أقل بشكل كبير. وهذا يشير إلى أن بعض الطبقات (المسارات) في شبكة الرواسب قد تكون زائدة عن الحاجة.

4-2-شبكة الرواسب كمجموعة من الشبكات الصغيرة

قدّم البحث [10] طريقة غير بديهية في تدريب شبكة عميقة جداً بحذف طبقات عشوائياً أثناء التدريب واستخدام كامل الشبكة أثناء الاختبار. أوجد فايت ورفاقه في [12] طريقة غير بديهية أكثر حيث يمكننا حذف بعض الطبقات من شبكة الرواسب المدربة والاحتفاظ بأداء مماثل. وهذا ما يجعل بنية شبكة الرواسب مثيرة للاهتمام بشكل كبير حيث [12] أيضاً حذف طبقات من شبكة VGG المدربة وأدى ذلك إلى انخفاض الأداء بشكل كبير.

يبين البحث [12] نظرة واضحة عن شبكة شبكة الرواسب من خلال تفكيك بنية الشبكة، فمن الواضح تماماً أن بنية شبكة الرواسب المؤلفة من عدد من الكتل الراسبة يكون لديها ضعفي هذا العدد من المسارات المختلفة كما يبين الشكل (12) (حيث أنّ كل بنية راسبة تولد مسارين مستقلين).

نظراً للنتيجة المذكورة، فإن حذف زوج من الطبقات لن يؤثر كثيراً على أداء الشبكة، حيث تحتوي بنية الشبكة على مسارات فعالة مستقلة أخرى وتبقى معظمها سليمة بعد الحذف، بينما على العكس تماماً، فإن شبكة VGG لديها مسار واحد فعّال فقط، وبالتالي فإن حذف طبقة ما سيؤثر على هذا المسار الوحيد. كما هو موضح في [12].

أجرى المؤلفون العديد من التجارب لاثبات أن مجموعة من المسارات في شبكة الرواسب لها سلوك يشبه سلوك المجموعة، لذلك قاموا بحذف عدد مختلف من الطبقات في وقت الاختبار ومعرفة فيما إذا كان أداء الشبكة مرتبط بعدد الطبقات المحذوفة. تشير النتائج أن سلوك الشبكة يشبه بالفعل مجموعة كما هو موضح في الشكل التالي.

أخيراً وبعد إمعان النظر في خصائص المسارات في شبكة الرواسب وجد الباحثون أن توزع أطوال المسارات الممكنة هو توزع ثنائي كما هو واضح في الشكل (14-a ) وأن معظم المسارات تمر من خلال 19 إلى 35 كتلة راسبة.

(a): التوزع الثنائي لأطوال المسارات الممكنة- (b) حجم التدرج حسب طول المسار(c) حجم التدرج الكلي حسب طول المسار

تم القيام بعدة تجارب من أجل اكتشاف العلاقة بين طول المسار وقيمة المشتق المتدفقة منه. فمن أجل الحصول على قيمة المشتق في مسار ذو طول معين، قام الباحثون أولاً بتقديم مجموعة من البيانات إلى الشبكة واختيار نفس العدد من الكتل الراسبة بشكل عشوائي يماثل طول المسار. وعند انتشار المشتق خلفاً فإنها تنتشر فقط عبر أوزان طبقة الكتل الراسبة المختارة. يوضح الشكل (14- (b أن حجم التدرج يتناقص بسرعة عندما يكون المسار أكثر طولاً.

يمكن مضاعفة تكرار كل طول مسار مع حجم التدرج المتوقع له لتحديد كم عدد المسارات من كل طول سيساهم في التدريب كما في الشكل(14-c). من المدهش أن معظم المساهمات تأتي من المسارات ذات طول من 9 إلى 18 لكنها تشكل جزء صغير من إجمالي المسارات كما في الشكل (14-a).

إن هذا الاكتشاف مثير للاهتمام لأنه يشير إلى أن شبكة الرواسب لا تحل مشكلة تضاؤل المشتق حتى الانعدام من أجل المسارات الطويلة جداً. وأن شبكة الرواسب يمكّنها بالفعل تدريب شبكة عميقة جدًا من خلال تقصير مساراتها الفعالة.

الخاتمة

قدمت هذه المقالة نظرة عامة حول بنية شبكة الرواسب وشرحت باختصار سر نجاحها مؤخراً، ثم عرضت أبحاثاً عديدة تقترح أشكال مختلفة من شبكة الرواسب وتقدم تفسيراً لها. كل الأشكال الموجودة في هذه المقالة مأخوذة من المراجع الأساسية للمقالات.

المراجع

- K. He, X. Zhang, S. Ren, and J. Sun. Deep residual learning for image recognition. arXiv preprint arXiv:1512.03385,2015.

- A. Krizhevsky, I. Sutskever, and G. E. Hinton. Imagenet classification with deep convolutional neural networks. In Advances in neural information processing systems, pages 1097–1105, 2012.

- K. Simonyan and A. Zisserman. Very deep convolutional networks for large-scale image recognition. arXiv preprint arXiv: 1409. 1556, 2014.

- C. Szegedy, W. Liu, Y. Jia, P. Sermanet, S. Reed, D. Anguelov, D. Erhan, V. Vanhoucke, and A. Rabinovich. Going deeper with convolutions. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 1–9, 2015.

- R. Srivastava, K. Greff, and J. Schmidhuber. Training Very Deep Networks. arXiv preprint arXiv:1507.06228v2,2015.

- S. Hochreiter and J. Schmidhuber. Long short-term memory. Neural Comput., 9(8):1735–1780, Nov. 1997.

- K. He, X. Zhang, S. Ren, and J. Sun. Identity Mappings in Deep Residual Networks. arXiv preprint arXiv:1603.05027v3, 2016.

- S. Xie, R. Girshick, P. Dollar, Z. Tu and K. He. Aggregated Residual Transformations for Deep Neural Networks. arXiv preprint arXiv:1611.05431v1, 2016.

- G. Huang, Z. Liu, K. Q. Weinberger, and L. Maaten. Densely Connected Convolutional Networks. arXiv:1608.06993v3, 2016.

- G. Huang, Y. Sun, Z. Liu, D. Sedra, and K. Q. Weinberger. Deep Networks with Stochastic Depth. arXiv:1603.09382v3, 2016.

- N. Srivastava, G. Hinton, A. Krizhevsky, I. Sutskever, and R. Salakhutdinov. Dropout: A Simple Way to Prevent Neural Networks from Overfitting. The Journal of Machine Learning Research 15(1) (2014) 1929–1958.

- A. Veit, M. Wilber, and S. Belongie. Residual Networks Behave Like Ensembles of Relatively Shallow Networks. arXiv:1605.06431v2, 2016.

- An Overview of ResNet and its Variant