مقدمة عن أهمية الشَّبكات العصبونيَّة الإرجاعيَّة RNN

تُعتبر الشبكات العصبونيّة من أقوى الأدوات المستخدمة في مجال الذّكاء الاصطناعي وتعلم الآلة، فهي قادرة على التعلم وتصنيفِ الأنماط بكفاءةٍ عالية، كما أنّها تتحلّى بقدرٍ عالٍ من الدّيناميكيّة.

ولكنّ الشبكات العصبونيّة التقليديّة تفتقر إلى القدرة على التخزين وربط الأحداث ببعضها، فمثلاً من السهل على شبكةٍ عصبيّةٍ ما التمييز بين نوعين مختلفين من الفواكه، ولكن من الصّعب عليها توقع أسعار البورصة أو إكمال النّصوص تلقائياً، وهنا تكمن أهمية الشبكات العصبيّة الإرجاعيّة RNN، فاحتواؤها على ذاكرةٍ يجعل منها أداةً فعالة في توقّع الأحداث المتتالية، ويفتح مجالاً جديداً بشكل كليّ لطرُقٍ جديدة في تعليم الآلة.

تمثيل الشَّبكات العصبونيَّة الإرجاعيَّة RNN

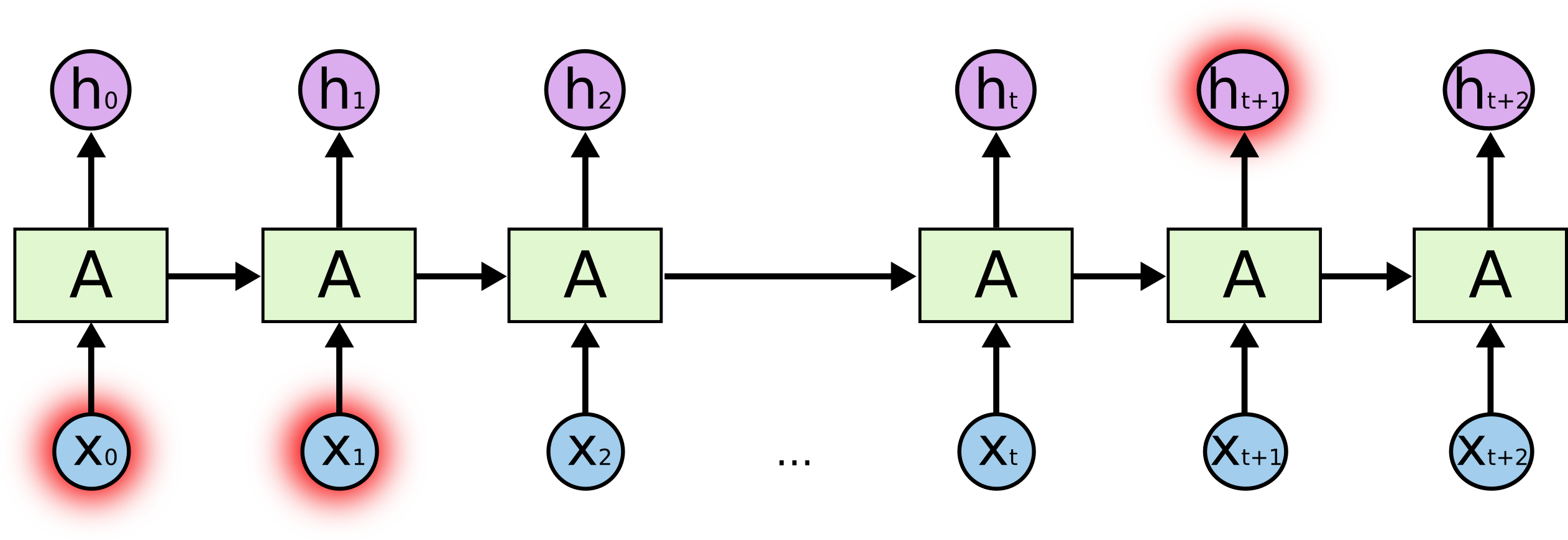

في الشكل 1 نلاحظ جزءاً من شبكةٍ عصبونيةٍ إرجاعيّة دخلها xt وخرجها htوتحوي على حلقةٍ إرجاعيّة،

تسمح هذه الحلقة بتمريرِ المعلومات من خطوةٍ إلى الخطوة التي تليها،

هذه الحلقات تضيف نوعاً من الغموض إلى الشبكة العصبونيّة الإرجاعية، ولكن في حقيقة الأمر هي مشابهة إلى حدٍّ كبير مع الشبكات العصبونيّة التقليديّة، فهي نِسَخ متلاحقة من نفس الشبكة كلّ منها تمرّر الرّسالة إلى الحلقة التالية

إنّ الطبيعة التسلسليّة للشبكات الإرجاعِيَّةِ تعطيها أفضليّة كبيرة في عددٍ من المجالات، منها التعرّف على النصوص والترجمة وتنصيص الصّور ….الخ

مشاكل الشبكات الإرجاعيَّة التقليديّة

- مشكلة الاعتماديّة طويلة المدى

القدرة على تذكر الأحداث هي أهمّ ميزة من ميزات الشبكات الإرجاعِيَّةِ ولكن ومع ازدياد طول الأحداث المترابطة تنشأ مشكلة تسمّى بالاعتماديّة طويلة المدى، وهنا تفقد الشبكات التراجعيّة البسيطة قدرتها على التعلّم والأداء بفاعليّة عالية

- مشكلة تلاشي المشتق vanishing gradient problem

تظهر هذه المشكلة مع ازدياد طول الشبكة، حيث تبدأ قيمة تابع الخسارة بالتّلاشي تدريجيّاً خلال عملية الانتشار الخلفيّ، وتصبح عملية تعديل الأوزان في الطبقات الأولى من الشبكة غير فعّالة، مما يجعل عملية التعلم بطيئة جداً وغير مُجدية.

مقدّمة عن الشَّبَكَات العُصبُونِيَّةِ ذاتِ الذَّاكِرةِ الطَّويلةِ قصيرةِ المَدى LSTM

تعتبر الشبكاتُ ذاتُ الذّاكرة الطويلة قصيرةِ المدى نوعاً محسّناً من الشبكات العصبونيّة التراجعيّة، ظهرت للمرّة الأولى على يد العالمَين جوزيف هورخيتر و يورغن شميتوبر Sepp Hochreiter & Jürgen Schmidhuber [4] في العام 1997

وكان الهدف الرئيسيّ من تصميمها هو تفادي مشاكل الشبكات العصبونيّة التراجعيّة البسيطة والحصول على نتائج أفضل.

الشكل التكراريّ للشبكاتِ ذاتِ الذّاكرة الطويلةِ قصيرة المدى LSTM

تحوي جميع الشبكات العصبونيّة التكراريّة على سلسلةٍ من الأنماط التكراريّة، وتكون هذه الأنماط في الشبكات العصبونيّة التكراريّة التقليديّة على هيئة طبقةٍ وحيدة من العصبونات التكراريّة

وتحتوي الشبكات ذات الذّاكرة الطويلة قصيرة المدى على سلسلة ايضاً، ولكن شكل هذه السّلسة مختلف فهي تحوي على أربع طبقاتٍ عوضاً عن طبقةٍ واحدة.

الفكرة الأساسيّة وراء الشبكات ذات الذّاكرة الطويلة قصيرة المدى LSTM

الهدف الرئيسيّ من تصميم الشبكاتِ ذاتِ الذّاكرة الطويلة قصيرة المدى والذي سنتعرّف عليه بالتفصيل لاحقاً_ هو التخفيف من وطأةِ الاعتماديّة طويلة المدى وتأثيرها السلبيّ على عملية التعلّم

بالإضافة إلى أنّ البواباتِ الأربع التي تعتمد عليها الشبكة في عملها، تساعد الشبكة على تذكر المعلومات الأكثر أهمية مما يحسّن جودة الخرج بشكلٍ كبير.

تأتي هذه الميزة على أهميةٍ كبيرة فمثلاً عندما نقرأ منشوراً إعلانيّاً يحوي على معلوماتٍ وتواريخ وأسعار، نتجاهل الكلماتِ غير الهامّة مثل حروف الجر والكلمات الزّائدة وهذا بالضبط ما تقوم به الشبكات ذات الذّاكرة الطويلة قصيرة المدى.

كيف تعمل الشبكات ذاتُ الذّاكرةِ الطويلة قصيرة المدى LSTM

مفتاح عمل الشبكات ذاتِ الذّاكرة الطويلة قصيرة المدى هي خلية الحالة cell state حيث تعتبر مثل الحزام النقّال، فهي تمرّ على طول السّلسلة بالكامل و تطرأ عليها تغيرات طفيفة خلال مرورها،

وبالتالي تعتبر وسيلةً جيدة للحفاظ على المعلومات بدون تغيير.

يوضح الشكل 8: خليّة الحالة ضمن الشبكة، حیث تملك الشبكات ذات الذّاكرة الطويلة قصيرة المدى القدرة على تغيير المعلومات ضمن خلية الحالة عن طريقِ بنيةٍ تعتمد على البوّابات المنطقيّة،

هذه البوّابات مكوّنة من مجموعة من طبقة عصبونيّة تنتهي بتابع التفعيل الأسي الجيبي Sigmoid ومجموعة من عمليّات الضرب الموجبة.

يكون خرج طبقة تابع التفعيل الأسي الجيبي Sigmoid بين الصّفر والواحد، تحدّد قيمته كمية المعلومات الواجب السماح بمرورها من كل عنصرٍ من عناصر الخلية.

تحوي الشبكاتِ ذاتِ الذّاكرة الطويلة قصيرة المدى ثلاث بوّابات منطقيّة للتحکّم بحالة الخلية

خطوات عمل الشبكاتِ ذاتِ الذّاكرة الطويلة قصيرة المدى LSTM

- الخطوة الأولى

اتخاذ قرارٍ حول المعلومات الواجب الاحتفاظ بها والمعلومات التي من الأفضل نسيانها من خلية الحالة، وتتمّ هذه العمليّة ضمن طبقة تابع التفعيل الأسي الجيبي والتي تسمّى بطبقة بوّابة النسيان forget gate layer

حيث يعتمد الخرج على ht-1 و xt وتكون قيمته بين 0 و 1.

بالعودة إلى مثال التوقّع اللغويّ حيث على الشبكة توقّع الكلمة التالية، ويجب الأخذ بعين الاعتبار بعض التغييرات على صياغة الجمل كتغيير الضمير من الغائب إلى المخاطب على سبيل المثال،

وهنا تكمن أهمية بوّابة النسيان.

- الخطوة التالية

تتمثّل بتحديد المعلومات الواجب تخزينها في خلية الحالة، و تتكوّن من جزئين:

أوّلاً طبقة تابع تدعى طبقة بوّابة الدّخل input gate layer مسؤولة عن تحديد القيمة التي ستتغير،

وثانياً طبقة تنتهي بتابع التفعيل الأسي الظلي Tanh تشکّل شعاعاً من القيم الجديدة المرشحة C~t من المحتمل إضافتها إلى خلية الحالة،

وفي الخطوة التالية سيتمّ دمج عمل الطبقتين لتعديلِ قيمة حالة الخلية.

وفي مثال التوقّع اللغويّ تفيد هذه الخطوة في تغيير الضمير مع المحافظة على الكلمة الأصليّة.

- الخطوة الثالثة

هي تعديل قيمة خلية الحالة السّابقة Ct−1 إلى القيمة الجديدة Ct

حيث نضرب قيمة الحالة القديمة ب ft ثم نضيف it∗C~t وهي القيمة الجديدة مضروبة بمعدل التّضخيم النّاتج عن تابع التفعيل الأسي الظلي

يمثل الشكل 12 تعديل قيمة الحالة،

وهنا يتمّ فعليّاً تغيير الضمير في الكلمة المتوقّعة بمثال التوقّع اللغويّ.

- الخطوة الرابعة و الأخيرة

هي تحديد الخرج النهائيّ، وهو مبنيّ على خرج خلية الحالة ولكن بعد القيام ببعض التعديلات :

أوّلاً نمرّر القيمة على طبقة تابع التفعيل الأسي الجيبي لنحدّد أيّ جزء من خلية الحالة سنختار، ثم نمرّر قيمة حالة الخلية عبر تابع التفعيل الأسي الظلي ونضربها بخرج طبقة تابع التفعيل الأسي الجيبي.

التغيّرات على الذّاكرة الطويلة قصيرة المدى LSTM

تحدثنا عن الشكلِ العامّ للشبكاتِ ذات الذّاكرة الطويلة قصيرة المدى، ولكن ليست جميع الشبكاتِ ذاتِ الذّاكرة الطويلة قصيرة المدى مصمّمة بهذا الشكل تماماً فهناك اختلافات بسيطة في معظم الأبحاث المتعلقة بها، وسنناقش بعض هذه الاختلافات

- إحدى النماذج من الشبكات ذاتِ الذّاكرة الطويلة قصيرة المدى تحوي وصلاتٍ تسمح لطبقات البوّابات الثلاثة بالوصول إلى خلية الحالة، طُرح هذا الشكل من قبل يورغن شميتوبر و فيلكس جيرز Felix Gers & jurgen Schmidhuber عام 2000 [5]

-

نموذج آخر يستخدم بوابتَي دخلٍ ونسيان مترابطتَين، فبدلاً من تحديدِ ما علينا إضافته وما علينا نسيانه بخلية الحالة بشكلٍ منفصل نقوم بالعمليتين في آنٍ معاً.

وبهذه الطريقة نقوم بتفعيل بوّابة النسيان فقط عندما نكون قرّرنا بالفعل تعديلَ قيمة خلية الحالة.

-

النموذج الأخير والأحدث ويسمى الشَّبَكَةُ العُصبونِيَّة ذاتُ البوَّاباتِ Gated Recurrent Unit GRU طُرح عام 2014 من قبل كيونيون شو Kyunghyun Cho [6] يدمج هذا النموذج بوّابة النسيان والدخل ببوّابةٍ وحيدة تسمى بوّابة التعديل update gate،

كما يدمج خلية الحالة cell state والخلية الخفيّة hidden state بالإضافة إلى تعديلاتٍ أخرى .

والشكل الناتج أبسط من الشبكات الإرجاعية ذات الذّاكرة الطويلة قصيرة المدى

هناك بالإضافة للأمثلة المذكورة العديد من النماذج للشبكات الإرجاعيّة ذات الذّاكرة الطويلة قصيرة المدى تختلف اختلافاتٍ بسيطة.

الخاتمة

تعتبر الشبكات الإرجاعيّة ذات الذّاكرة الطويلة قصيرة المدى من أهم التطورات التي طرأت على الشبكات الإرجاعيّة، والتي فتحت المجال لنتائجَ أفضل ومهامّ عديدة لم تكن الشبكات التقليديّة قادرةً على أدائها، حيث وصلت الشبكات الإرجاعيّة في مرحلةٍ من المراحل إلى طريق مسدود بالمهام التي حققها.

و يعدّ الجيل الجديد من الشبكات الإرجاعيّة عنصراً هامّاً في منظومة الشبكات العصبونيّة، ويُعتمد عليه في مجالاتٍ عديدة وهامة كما أن التطوّر والأبحاث الجديدة تفتح الباب أمام مجالاتٍ جديدة مستقبلاً.

المراجع

[1]-Understanding LSTM Networks — colah’s blog

[2]-52 Responses to A Gentle Introduction to Long Short-Term Memory Networks by the Experts

[4]-LONG SHORT-TERM MEMORY 1 INTRODUCTION

تعليقان

السلام عليكم شكرا جزيلا على الشرح الوافي ، هل ممكن شرح Attention_based RNN-LSTM

السلام عليكم شكرا جزيلا على الشرح الوافي ، هل من الممكن شرح Attention-based RNN-LSTM