- إعداد: د. سماح عثمان

- التّدقيق العلمي: د. حسن قزّاز، م. محمّد سرميني

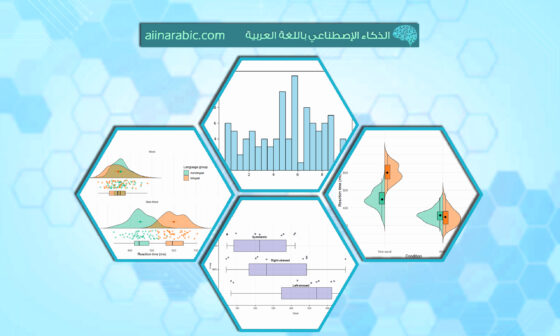

المحتويات

- 1- المقدمة

- 2- ماهي تقنية t-SNE

- 3- الفرق بين تحليل المكونات الأساسية وتضمين الجوار العشوائي

- 4- تضمين الجوار العشوائي الموزع على شكل حرف تي t-SNE:

- 5- ماهي تقنية تقليل الأبعاد

- 6- تطبيق عملي

- 7- تركيب وتحويل خوارزمية تحليل العنصر الأساسي

- 8- التمثيل المرئي باستخدام t-SNE

- 9- تركيب وتحويل t-SNE

- 10- مجموعة بيانات العملاء المستخدمة

- 11- تقليل الأبعاد (PCA Dimensionality Reduction)

- 12- التحقّق من الإرباك (Perplexity) مقابل الإختلاف (Divergence)

- 13- تقليل الأبعاد لتقنية t-SNE

- 14- تطبيقات تستخدم تقنية t-SNE

- 15- الخاتمة

- 16- المراجع

- الكاتب

تعتبر تقنية تضمين الجوار العشوائي الموزع (t-SNE) أسلوبًا إحصائيًا لتمثيل البيانات ذات الأبعاد العالية من خلال تعيين موقع لكل نقطة بيانات في مساحة ذات أبعاد منخفضة، سواء كانت ثنائية الأبعاد أو ثلاثية الأبعاد. تستند هذه التقنية إلى مفهوم تضمين الجوار العشوائي الموزع Stochastic Neighbor Embedding الذي تم تطويره بواسطة جيفري هينتون وسام الرويس، وقد قام لورنس فان دير ماتن بتعديله بإضافة المتغير الموزع t-distributed. تعد t-SNE تقنية غير خطية لتقليل الأبعاد تستخدم لتضمين البيانات ذات الأبعاد العالية في مساحة منخفضة الأبعاد ذات بعدين أو ثلاثة أبعاد. بشكل محدد، تقوم بتمثيل كل كائن ذو أبعاد عالية من خلال نقطة ذات أبعاد منخفضة، حيث يتم تشكيل الأجسام المتشابهة من خلال تجاور النقاط القريبة من بعضها البعض، بينما يتم تشكيل الأجسام غير المتشابهة من خلال تباعد النقاط البعيدة عن بعضها البعض بمعدل عالٍ من الاحتمال.

1- المقدمة

نتناول في هذه المقالة كيفيَة عمل التمثيل المرئي للبيانات باستخدام t-SNE ثم نقارنها بتقنية شائعة أخرى، وهي تقنية تحليل العنصر الأساسي (Principal Component Analysis)، نوضَح كيفيّة تنفيذ كلّ من تقنية t-SNE وPCA باستخدام مكتبة scikit-learn والتعبير عن الرسم على مجموعات البيانات الاصطناعية والواقعية. وسوف يتم تنفيذ الأمثلة في هذه المقالة باستخدام مكتبات بايثون.

2- ماهي تقنية t-SNE

t-SNE (تضمين الجوار العشوائي الموزع على شكل حرف t-SNE تقنية لتقليل الأبعاد غير الخطيّة غير الخاضعة للرقابة لاستكشاف البيانات و التّمثيل المرئي للبيانات عالية الأبعاد. المقصود من تقليل الأبعاد غير الخطية أن الخوارزمية تسمح لنا بفصل البيانات التي لا يمكن فصلها بخط مستقيم.

يمنحك t-SNE إحساسًا وحدسًا حول كيفية ترتيب البيانات في أبعاد أعلى. غالبًا ما يتم استخدام التمثيل المرئي للبيانات المعقدة والتي تكون في بعدين وثلاثة أبعاد، مما يسمح لنا بفهم المزيد عن الأنماط والعلاقات الأساسية بين البيانات [1].

3- الفرق بين تحليل المكونات الأساسية وتضمين الجوار العشوائي

يعدّ كل منهما من تقنيات تقليل الأبعاد التي لها آليات مختلفة وتعمل بشكل أفضل مع أنواع مختلفة من البيانات. فعلى سبيل المثال نجد أن تقنية تحليل المكونات الأساسية هو أسلوب خطي يعمل بشكل أفضل مع البيانات ذات البنية الخطية. ويسعى إلى تحديد المكونات الأساسية في البيانات من خلال الإسقاط على أبعاد أقل، وتقليل التباين، والحفاظ على مسافات زوجية كبيرة. يمكنك عزيزي القارئ الاطلاع على تفاصيل أكثر من خلال المقال التالي عن طريقة عمل تحليل العنصر الأساسي [2].

ومن جهة أخرى نجد أن تقنية تضمين الجوار العشوائي الموزع علي حرف تيT، هي تقنية غير خطية تركز على الحفاظ على أوجه التشابه الزوجيّة بين نقاط البيانات في مساحة ذات أبعاد أقل. وتهتم هذه التقنية بالحفاظ على مسافات زوجية صغيرة بينما يركز تحليل العنصر الأساسي على الحفاظ على مسافات زوجية كبيرة لزيادة التباين إلى أقصى حد.

باختصار، يحافظ PCA على التباين في البيانات، في حين يحافظ t-SNE على العلاقات بين نقاط البيانات في مساحة منخفضة الأبعاد، مما يجعلها تقنية جيّدة تستخدم في عمليات التمثيل المرئي للبيانات المعقّدة عالية الأبعاد.

4- تضمين الجوار العشوائي الموزع على شكل حرف تي t-SNE:

تعمل تقنية تقليل الأبعاد على قياس التشابه بين أزواج المتشابهات في مساحة الأبعاد العالية والأبعاد المنخفضة. تتألف العملية من ثلاث خطوات رئيسية:

1. خطوة النمذجة (Modeling): تستخدم الخوارزمية المعروفة بـ t-SNE (t-Distributed Stochastic Neighbor Embedding) لنمذجة نقاط البيانات في الأبعاد العالية والأبعاد المنخفضة. يتم حساب التشابه الزوجي بين جميع نقاط البيانات في الفضاء العالي الأبعاد باستخدام نواة غاوسية (Gaussian Kernel). تتمثل الفكرة في أن النقاط المتباعدة تكون لديها احتمالية أقل للالتقاء مع النقاط الأخرى القريبة منها [3].

2. خطوة التضمين (Embedding): تهدف الخوارزمية إلى تعيين نقاط البيانات في الأبعاد العالية على مساحة أبعاد منخفضة محافظة على التشابه الزوجي بينها. يتم بناء التضمين من خلال تحسين توزيع الاحتمالية للأبعاد العالية والأبعاد المنخفضة باستخدام تقنيات مثل الانضغاط المتدرج (Gradient Compression). يهدف ذلك إلى تحقيق توازن بين الحفاظ على بنية البيانات وتقليل الأبعاد.

3. خطوة التحسين (Optimization): تهدف هذه الخطوة إلى تحسين التضمين المنخفض الأبعاد للوصول إلى حالة مستقرة ومرضية. يتم ذلك من خلال تعديل المسافات والتوزيعات في الأبعاد المنخفضة بناءً على قيم الاختلاف بين التوزيعات الاحتمالية للأبعاد العالية والأبعاد المنخفضة. تستخدم الخوارزمية تقنيات التحسين المتعددة للوصول إلى حالة مستقرة وتحسين تمثيل البيانات في الأبعاد المنخفضة [4].

عملية التحسين والتضمين تسمح بتجميع وتجميع مجموعات فرعية من نقاط البيانات المماثلة في الفضاء ذي الأبعاد المنخفضة. يمكن تصور هذه المجموعات لفهم البنية والعلاقات في البيانات الأصلية ذات الأبعاد العالية.

5- ماهي تقنية تقليل الأبعاد

تتمثل العملية في تحويل البيانات ذات الأبعاد العالية إلى بيانات ذات أبعاد منخفضة مع الحفاظ على الخصائص الرئيسية. توجد تطبيقات لهذه التقنية في العديد من الصناعات، بما في ذلك التمويل الكمي والرعاية الصحية واكتشاف الأدوية. من المهم أن يكون لدى علماء البيانات معرفة ببعض الأساليب الحديثة لتنفيذ عملية تقليل الأبعاد بفعالية [1] [3].

6- تطبيق عملي

في هذا الجزء من المقال سنقوم بإنشاء بيانات التصنيف، وتنفيذ كلا التقنيتين اولاً تقنية تحليل العنصر الأساسي وثانياً تقنية تضمين الجوار العشوائي الموزع على شكل حرف تي t-SNE، بعد ذلك سوف نعمل على معرفة الفرق في التقنيتين باستخدام التمثيل المرئي لكل النتائج و للتمثيل المرئي، سنستخدم دالة Plotly Express.أما فيما يخص عملية تقليل الأبعاد، سنستخدم مكتبة Scikit-Learn. ثم دالة make_classification الموجودة في مكتبة Scikit-Learn لإنشاء بيانات تركيبيّة تحتوي على 6 ميزات و1500 عينة و3 فئات. بعد ذلك، سنقوم برسم الميزات الثلاثة الأولى للبيانات بشكل ثلاثي الأبعاد باستخدام دالة Plotly Express scatter_3d.

سوف نبدأ باستيراد هذة الوحدة النمطية ploly.express كـ px والدالة make_classification من الوحدة النمطية sklearn.datasets. وذلك من خلال الشيفرة البرمجية التالية:

import plotly.express as px

from sklearn.datasets import make_classification

- يتم بعد ذلك استخدام دالة make_classification لإنشاء مجموعة بيانات تحتوي على 6 ميزات و3 أصناف و1500 عينة.

- تحدّد المعلمة n_informative عدد الخصائص للبيانات المختارة ، بينما تضمن Random_state أن مجموعة البيانات قابلة للتكرار.

- تحدد n_clusters_per_class عدد المجموعات لكلّ صنف.

- يتمّ تعيين مجموعة البيانات التي تم إنشاؤها والتسميات المقابلة للمتغيرين X وY، على التوالي.

- بعد ذلك، يتم استخدام الدالة px.scatter_3d لإنشاء مخطط مبعثر ثلاثي الأبعاد لمجموعة البيانات كما يظهر الشكل (1).

- تحدد المعلّمات x وy وz الميزات المراد رسمها على كل محور، بينما تقوم معلّمة اللون بتعيين لون لكل فئة.

- تحدد معلمة العتامة شفافيّة النقاط.

- وأخيرا، يتم استدعاء الدالّة Show لعرض التمثيل المرئي للبيانات وتظهر النتيجة كما في الشكل (1).

X, y = make_classification(

n_features=6,

n_classes=3,

n_samples=1500,

n_informative=2,

random_state=5,

n_clusters_per_class=1,

)

fig = px.scatter_3d(x=X[:, 0], y=X[:, 1], z=X[:, 2], color=y, opacity=0.8)

fig.show()

7- تركيب وتحويل خوارزمية تحليل العنصر الأساسي

سنقوم الآن بتطبيق خوارزمية تحليل العنصر الأساسي PCA على مجموعة البيانات لاستخلاص أفضل خاصيتان لتمثيل البيانات [1]. يتعلم التابع fit_transform مجموعة البيانات ويحولها في نفس الوقت.

- سنقوم باستيراد مكتبات تحليل العنصر الأساسي من مكتبة scikit-Learn باستخدام العبارة from.

- بعد ذلك نقوم بإنشاء مثيل لفئة تحليل العنصر الأساسي مع تعيين n_components على 2، مما يعني أن خوارزمية تحليل العنصر الأساسي سوف تستخدم لتقليل أبعاد بيانات الإدخال إلى مكونين رئيسيّين.

- وأخيرًا، يتم تطبيق تحويل خوارزمية تحليل العنصر الأساسي على بيانات الإدخال X باستخدام طريقة fit_transform، والتي تقوم بإرجاع البيانات المحولة X_pca.

- ستحتوي البيانات المحوّلة X_pca على أعمدة أقل من البيانات الأصلية X، مما يسهل عملية التمثيل المرئي للبيانات وتحليلها.

from sklearn.decomposition import PCA

pca = PCA(n_components=2)

X_pca = pca.fit_transform(X)

8- التمثيل المرئي باستخدام t-SNE

يمكننا الآن تصور النتائج من خلال عرض مكونين من مكونات PCA على مخطّط مبعثر.

- X: المكون الأول

- Y: المكون الثاني

- اللون: متغير الهدف.

لقد استخدمنا أيضًا الدالة update_layout لإضافة عنوان وإعادة تسمية المحور X والمحور Y ويكون التمثيل المرئي للبيانات عند استخدام طريقة t-SNE كما في الشكل (2).

fig = px.scatter(x=X_pca[:, 0], y=X_pca[:, 1], color=y)

fig.update_layout(

title="PCA visualization of Custom Classification dataset",

xaxis_title="First Principal Component",

yaxis_title="Second Principal Component",

)

fig.show()

9- تركيب وتحويل t-SNE

سنقوم الآن بتطبيق تقنية t-SNE على مجموعة البيانات ومقارنة النتائج. بعد تركيب البيانات وتحويلها، سوف نعرض تباعد كولباك ليبلر Kullback-Leibler بين التوزيع الاحتمالي عالي الأبعاد والتوزيع الاحتمالي منخفض الأبعاد. من خلال الشيفرة البرمجية التالية [1]:

- يستورد هذا الرمز فئة TSNE من وحدة sklearn.manifold، والتي تُستخدم لتقليل الأبعاد وتمثيل البيانات عالية الأبعاد.

- بعد ذلك، يتم إنشاء مثيل لفئة TSNE باستخدام n_components=2 وrandom_state=42.

- تحدد n_components=2 أنه ينبغي تقليل أبعاد بيانات المخرجات إلى بعدين، وهو ما يناسب أغراض التصور.

- Random_state=42 يعين البذرة العشوائية للتكاثر.

- بعد ذلك، يتم استدعاء الأسلوب fit_transform لمثيل TSNE باستخدام X كوسيطة لها.

- يُفترض أن تكون X مجموعة بيانات عالية الأبعاد.

- تقوم هذه الطريقة بإرجاع البيانات المحوّلة في بعدين، والتي تم تخصيصها للمتغير X_tsne.

- أخيرًا، يتم الوصول إلى سمة kl_divergence_ لمثيل TSNE، والتي تُرجع تباعد Kullback-Leibler بعد التحسين.

- يمكن استخدام هذا كمقياس لمدى التقارب عند استخدام هذه التقنية. ويكون المخرج كما في ال output

from sklearn.manifold import TSNE

tsne = TSNE(n_components=2, random_state=42)

X_tsne = tsne.fit_transform(X)

tsne.kl_divergence_

الخرج:

1.1169137954711914

الأن بنفس الطريقة المستخدمة في خوارزمية تحليل العنصر الأساسي لمشاهدة التمثيل المرئي للبيانات باستخدام تقنية t-SNE سوف نقوم بإسقاط مكونين فقط كما تظهر النتيجة في الشكل (3) وذلك باستخدام الشيفرة البرمجية التالية:

- يستخدم هذا الرمز مكتبة Plotly Express لإنشاء مخطط مبعثر لتصور ثنائي الأبعاد t-SNE (T-Distributed Stochastic Neighbor Embedding) مجموعة بيانات تصنيف مخصصة.

- يتم ارسال قيم الإحداثيات (x,y) الي الدالة scatter وذلك لتحديد لون النقاط في التمثيل المرئي.

- يقوم متغير الشكل بتخزين كائن الرسم الناتج.

- يتم استخدام الدالة Fig.update_layout لتحديد شكل المساحة المستخدمة عند عرض البيانات، بما في ذلك تسميات العنوان والمحور.

- وأخيرا، يتم استدعاء الدالة Fig.show لعرض التمثيل المرئي للبيانات كما في الشكل (3)

fig = px.scatter(x=X_tsne[:, 0], y=X_tsne[:, 1], color=y)

fig.update_layout(

title="t-SNE visualization of Custom Classification dataset",

xaxis_title="First t-SNE",

yaxis_title="Second t-SNE",

)

fig.show()

10- مجموعة بيانات العملاء المستخدمة

في هذا القسم، سنستخدم مجموعة بيانات العملاء الحقيقية لشركة اتصالات [5]. تحتوي مجموعة البيانات على معلومات حول نشاط العملاء، مثل حالات فشل المكالمات وطول الاشتراك وتسمية الإيقاف.

Churn يعني النسبة المئوية للعملاء الذين يتوقفون عن استخدام خدمة معينة خلال فترة زمنية معينة.

سنقوم باستيراد بيانات العملاء ومن ثم عرض الصفوف الخمسة الأولى منها كما تظهر في الشكل (4) وذلك من خلال الشيفرة البرمجية التالية [1]:

import pandas as pd

df = pd.read_csv("customer.csv")

df.head(5)

11- تقليل الأبعاد (PCA Dimensionality Reduction)

في هذا الجزء سنقوم بمحاولة تقليل الأبعاد في تقنية تحليل العنصر الأساسي من خلال الشيفرة البرمجية التالية:

- إنشاء الميّزات (X) والهدف (y) باستخدام عمود Churn.

- تطبيع الميزات باستخدام إشارة قياسية.

- تقسيم مجموعة البيانات إلى مجموعة تدريب واختبار.

- تطبيق تقنية تحليل العنصر الأساسي على مجموعة بيانات التدريب.

- سنحصل على النتيجة باستخدام مجموعة بيانات الاختبار و تتمثل في حساب متوسط عينات الاختبار. وسوف نلاحظ أن النتيجة تكون قيمة سلبية وخاطئة في نفس الوقت مما يعني أن استخدام الدالة score في هذا السياق غير صحيحة لانها تؤدي الى نتائج خاطئة [3].

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

X = df.drop('Churn', axis=1)

y = df['Churn']

scaler = StandardScaler()

X_norm = scaler.fit_transform(X)

X_train, X_test, y_train, y_test = train_test_split(

X_norm, y, random_state=13, test_size=0.25, shuffle=True

)

pca = PCA(n_components=2)

X_train_pca = pca.fit_transform(X_train)

pca.score(X_test)

الخرج:

-17.04482851288105

الآن نشاهد التمثيل المرئي للبيانات نتيجة استخدام خوارزمية تحليل العنصر الأساسي كما هو مبين في الشكل (5) وذلك من خلال استخدام مخطّط التشتّت Plotly Express كما في الشيفرة البرمجة التالية [1]:

fig = px.scatter(x=X_train_pca[:, 0], y=X_train_pca[:, 1], color=y_train)

fig.update_layout(

title="PCA visualization of Customer Churn dataset",

xaxis_title="First Principal Component",

yaxis_title="Second Principal Component",

)

fig.show()

نلاحظ من الشكل (5) إن تقنية تحليل العنصر الأساسي لم تكن جيدة في إنشاء المجموعات. وتبدو البيانات الموجودة في البعد المنخفض عشوائية. وقد يعني ذلك أن الميزات الموجودة في مجموعة البيانات منحرفة للغاية، أو أنها لا تحتوي على بنية ارتباط قوية.

12- التحقّق من الإرباك (Perplexity) مقابل الإختلاف (Divergence)

أما بالنسبة لتقنية تضمين الجوار العشوائي الموزع على شكل حرف تي t-SNE، فإن الإرباك يعتبر معلمة أساسيّة (hyperparameter) شديدة الإرباك مهمة جدًا. فهو يتحكم في العدد الفعّال للجوار الذين تأخذهم كل نقطة في الاعتبار أثناء عملية تقليل الأبعاد، وسوف نلاحظ ذلك من خلال تطبيق الشيفرة البرمجية التالية:

- استيراد مكتبةُ بايثون العدديَّةُ NumPy من ثم انشيْ مصفوفة تسمى perplexity باستخدام الدالة arange من NumPy.

- تقوم الدالة arange بإنشاء مصفوفة من القيم المتباعدة بالتساوي بين قيمة البداية (5) وقيمة النهاية (55) بحجم خطوة قدره 5.

- يتم أيضًا إنشاء قائمة فارغة تسمى التباعد.

- تقوم الشيفرة البرمجية بعد ذلك بإدخال حلقة for التي تتكرر فوق كل قيمة في مصفوفة الإرباك (perplexity).

- داخل الحلقة، يتم إنشاء نموذج t-SNE بمكونين، تتم تهيئته باستخدام PCA، مع ضبط قيمة الإرباك على القيمة الحالية i.

- يتم بعد ذلك استدعاء الأسلوب fit_transform على النموذج باستخدام بيانات X_train.

- يتم بعد ذلك إلحاق تباعد KL للنموذج بقائمة التباعد.

- بعد اكتمال الحلقة، يتم استخدام الدالة px.line من مكتبة Plotly Express لإنشاء مخطط خطي مع الإرباك كمحور x والتباعد كمحور y.

- تم ضبط وسيطة العلامات على True لعرض العلامات عند كل نقطة بيانات.

- يتم استخدام طريقة update_layout لتعيين عناوين المحور x والمحور y، ويتم استخدام طريقة update_traces لتعيين لون الخط إلى اللون الأحمر وعرض الخط على 1.

- يتم عرض النتيجة باستخدام طريقة show كما تظهر في الشكل (6).

import numpy as np

perplexity = np.arange(5, 55, 5)

divergence = []

for i in perplexity:

model = TSNE(n_components=2, init="pca", perplexity=i)

reduced = model.fit_transform(X_train)

divergence.append(model.kl_divergence_)

fig = px.line(x=perplexity, y=divergence, markers=True)

fig.update_layout(xaxis_title="Perplexity Values", yaxis_title="Divergence")

fig.update_traces(line_color="red", line_width=1)

fig.show()

أصبح تباعد KL ثابتًا بعد 40 درجة من الإرباك. لذلك، سوف نستخدم 40 إرباك في خوارزمية تضمين الجوار العشوائي الموزع على شكل حرف تي t-SNE.

13- تقليل الأبعاد لتقنية t-SNE

سنقوم الآن بتركيب t-SNE وتحويل البيانات إلى أبعاد أقل باستخدام 40 درجة من الإرباك للحصول على أدنى اختلاف في KL.

وذلك باستخدام الشيفرة البرمجية التالية:

- يّستورد هذا الرمز فئة TSNE من الوحدة النمطية sklearn.manifold.

- يقوم بعد ذلك بإنشاء مثيل لفئة TSNE بـ n_components=2، مما يعني أن التضمينات الناتجة سيكون لها بعدين.

- تتحكم معلمة الإرباك في التوازن بين الحفاظ على البنية التركيبية للبيانات، وتقوم Random_state بتعيين البذرة العشوائية لإمكانية التكاثر.

- يتم بعد ذلك استدعاء طريقة fit_transform لكائن TSNE في مجموعة بيانات X_train، وهي البيانات المدخلة التي نريد تقليل أبعادها.

- تقوم هذه الطريقة بإرجاع البيانات المحولة و المخزنة في المتغير X_train_tsne.

- وأخيرًا، يتم الوصول إلى سمة kl_divergence_ لكائن TSNE، والتي تُرجع تباعد Kullback-Leibler بين بيانات الإدخال و البيانات المضمنة.

- يمكن استخدام هذا كمقياس لمدى نجاح عملية التضمين في التقاط بنية البيانات الأصلية.

from sklearn.manifold import TSNE

tsne = TSNE(n_components=2,perplexity=40, random_state=42)

X_train_tsne = tsne.fit_transform(X_train)

tsne.kl_divergence_

الخرج:

0.258713960647583

سنستخدم الآن مخطط Plotly Scatter لعرض المكونات والفئات المستهدفة وذلك باستخدام الشيفرة البرمجية التالية

- يتم استخدام مكتبة ploly.express لإنشاء مخطط مبعثر للبيانات X_train_tsne، حيث يكون المحور x هو العمود الأول من X_train_tsne والمحور y هو العمود الثاني من X_train_tsne.

- يتم تحديد لون كل نقطة من خلال بيانات y_train.

- يتم استخدام طريقة update_layout لإضافة عنوان إلى المخطط وتسمية المحورين x وy.

- وأخيرًا، يتم استدعاء طريقة العرض لعرض النتيجة كما في الشكل (7).

fig = px.scatter(x=X_train_tsne[:, 0], y=X_train_tsne[:, 1], color=y_train)

fig.update_layout(

title="t-SNE visualization of Customer Churn dataset",

xaxis_title="First t-SNE",

yaxis_title="Second t-SNE",

)

fig.show()

كما هو واضح في الشكل (7)، لدينا مجموعات ومجموعات فرعية متعددة. يمكننا استخدام هذه المعلومات لفهم النمط والتوصّل إلى استراتيجية للاحتفاظ بالعملاء الحاليين.

14- تطبيقات تستخدم تقنية t-SNE

بصرف النظر عن طرق التمثيل المرئي للبيانات المعقّدة متعدّدة الأبعاد، فإن خوارزمية تضمين الجوار العشوائي الموزع على شكل حرف تي T-SNE لها استخدامات أخرى معظمها في المجال الطبي هنا نذكر بعض الأمثلة على ذلك [1]:

- التجميع والتصنيف: تجميع نقاط البيانات المتشابهة معًا في مساحة ذات أبعاد أقل. ويمكن استخدامها أيضًا للتصنيف وإيجاد الأنماط في البيانات.

- كشف الشذوذ: لتحديد القيم المتطرفة والشذوذ في البيانات.

- معالجة اللغة الطبيعية: التمثيل المرئي يتضمن الكلمات الناتجة عن مجموعة كبيرة من النصوص مما يسهل تحديد أوجه التشابه والعلاقات بين الكلمات.

- أمن الحاسوب: التمثيل المرئي لأنماط حركة مرور الشبكة واكتشاف الحالات الشاذّة.

- أبحاث السرطان: التمثيل المرئي للملامح الجزيئية لعينات الورم وتحديد الأنواع الفرعيّة للسرطان.

- تفسير المجال الجيولوجي: التمثيل المرئي للخصائص الزلزالية وتحديد الشذوذات الجيولوجية.

15- الخاتمة

عزيزي القارئ أرجو أن تكون اتضحت لك الرؤية والفرق بين استخدام تقنية تحليل العنصر الأساسي PCA وتضمين الجوار العشوائي الموزع علي شكل حرف تي t-SNE. وذلك أن تقنية تضمين الجوار العشوائي الموزع على شكل حرف تي t-SNE تعتبر أداة قوية تعطي نتائج فعالة للكشف عن الأنماط والهياكل المخفية في مجموعات البيانات المعقدة وذلك من خلال التمثيل المرئي للبيانات. بالإضافة إلى إمكانية استخدامها مع أنواع مختلفة من البيانات مثل الصور والصوت والبيانات البيولوجية والبيانات الفردية لتحديد الحالات الشاذة والأنماط.

بالاضافة الى أن تقنية تضمين الجوار العشوائي الموزع على شكل حرف تي t-SNE، وهي تقنية شائعة لتقليل الأبعاد يمكنها عمل التمثيل المرئي للبيانات الغير خطية عالية الأبعاد في مساحة منخفضة الأبعاد. لقد قمنا في هذه المقالة بشرح الفكرة الرئيسية وراء t-SNE وكيفية عمله وتطبيقاته. علاوة على ذلك، أظهرنا بعض الأمثلة على تطبيق تقنية تضمين الجوار العشوائي الموزع على شكل حرف تي t-SNE على المواد التركيبية ومجموعات البيانات الحقيقية وكيفية تفسير النتائج.