إعداد: د.م. سالي محمّد

التّدقيق العلمي: د.م. دانيا صغير، م. محمّد سرميني

خلاصة البحث

تعدّ عمليّات تضمين النّصّ من المميّزات المفيدة في العديد من التّطبيقات؛ مثل البحث الدّلاليّ semantic search وحساب تشابه النّصّ text similarity، الابحاث السّابقة تقوم بالتّدريب عادة على نماذج مخصّصة لحالات مختلفة من الكثير من النّواحي؛ منها ناحية الاستخدام واستخدام البيانات التي يتمّ التّدريب عليها، والهدف من التّدريب، وكيفيّة بناء النّموذج في هذا العمل. نوضّح أنّ التّدريب التّناقضيّ المسبق على البيانات غير الخاضعة للإشراف unsupervised data على نطاق واسع، يؤدّي إلى تمثيلات موجّهة عالية الجودة في التّمثيل النّصّيّ والبرمجيّ. كما نعرض نفس عمليّات التّضمين النّصّيّة غير الخاضعة للرّقابة، والتي تحقّق نتائج جديدة على أحدث طراز في تحقيق التّصنيف الخطّيّ linear classification، وإمكانيّات البحث الدّلالي رائعة وأحيانًا تُؤدّى بشكل تنافسيّ باستخدام نماذج مضبوطة بدقّة. دقّة تصنيف التّحقّق الخطّيّ شملت سبع مهام، وقد حقّق هيكلنا المكتشف نسبة تطوير من 1.8% إلى 4% نسبة إلى جميع ماسبق من دراسات أنظمة التّضمين غير الخاضعة للإشراف والإشراف على نفس نصّ التّضمين، و عندما يتمّ تقييمه على حجم أعلى فإنّه يعطي تحسينًا بنسبة (23.4%-14.7%-10.6%) على ما سبق من الأنظمة السّابقة؛ وهي MSMARCO و الأسئلة الطّبيعيّة Natural Questions وTriviaQA على التّوالي، نفس الشّيء بالنّسبة لعمليّات تضمين النّصّ text embeddings، حيث نقوم بتدريب نماذج تضمين الكود على أزواج (نص، رمز)، والحصول على تحسين نسبيّ بنسبة 20 ممّا سبق عمله في هذا المجال.

1. المقدّمة

شهد التّعلّم العميق غير الخاضع للإشراف باستخدام النّماذج التّوليديّة والتّضمينيّة generative and embedding models نجاحًا كبيرًا في السّنوات القليلة الماضية.

النّماذج التّوليديّة ومن أمثلتها (Peters et al., 2018; Raffel et al., 2019; van den Oord et al., 2016; Ramesh et al., 2021; Brown et al., 2020; Chen et al., 2021) يتمّ تدريبهم على زيادة احتماليّة البيانات المرصودة إلى أقصى حدّ، بينما يتمّ تدريب نماذج التّضمين على التّمييز بين البيانات المرصودة والضّوضاء (Sohn, 2016; van den Oord et al., 2018; Radford et al., 2021; Jia et al., 2021; Gao et al., 2021; Izacard et al., 2021).

تنتج النّماذج التّوليدية Generative models محتوى أكثر واقعيّة وتستفيد من العديد من التّطبيقات النّهائيّة، ممّا يقلّل من الحاجة إلى مجموعات بيانات التّدريب المصنّفة. في النّماذج التّوليدية عادةً ما يتمّ توزيع المعلومات حول المدخلات على حالات عديدة مختفية للنّموذج، في حين أنّ بعض النّماذج التّوليديّة يمكن أن تتعلّم تمثيلًا واحدًا للمدخلات، لذلك فإنّ معظم المحولات يكون لها معامل انحدار ذاتيّ (Vaswani et al., 2017) models do not (Raffel et al., 2019; Brown et al., 2020; Chen et al., 2021; Ramesh et al., 2021). ومع ذلك، فإنّ تعلّم مثل هذا التضمين ضروريّ للعديد من المهام، ويتطلّب الأنظمة التي تبحث في ملايين أو مليارات العناصر أن يتمّ تضمين كلّ إدخال كتمثيل كثيف، وإنشاء فهرس مسبقًا لتوفير الوقت أثناء الاستعلام عن هذه المدخلات. تعتبر عمليّات التّضمين هذه من المميّزات المفيدة لمهام التّصنيف، ويمكنها أيضًا تمكين تطبيقات تصوّر البيانات عبر تقنيّات مثل التّجميع، تمّ تحسين نماذج التّضمين بشكل صريح لتعلّم تمثيل منخفض الأبعاد وذلك بالتقاط المعنى الدّلالي للمدخلات. (Radford et al., 2021; Jia et al., 2021; Giorgi et al., 2020; Gao et al., 2021; Izacard et al., 2021).

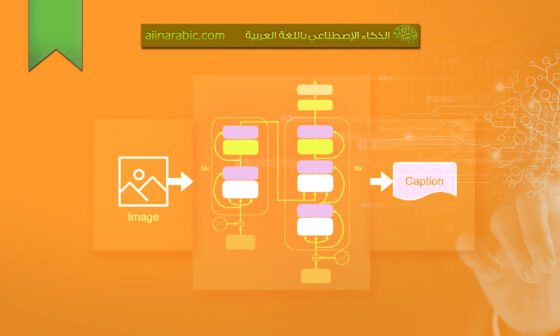

في هذا العمل نقوم بتدريب نماذج التّضمين باستخدام التّعلّم الهدفيّ المتباين contrastive learning objective مع الازواج السلبيه دفعة واحدة على البيانات غير المسمّاة. يتمّ تشفير المدخلات باستخدام مُشفّر المحوّل transformer encoder، ونستفيد من البيانات التي تم تدريبها بشكل طبيعيّ لإنشاء بيانات التّدريب بدون تسميات صريحة. يتمّ تدريب نماذج تضمين النّصّ على بيانات نصّيّة مقترنة paired text data، حيث نعتبر قطع النّصّ المجاورة على الإنترنت أزواجًا إيجابيّة positive pairs. تتعامل نماذج تضمين الكود مع سلسلة المستندات ذات المستوى الأعلى في دالة جنبًا إلى جنب مع تنفيذها على أنّها أزواج من (نص، رمز). إشارة التّدريب للهدف المتباين لايكفي لتعلّم مخرجات مفيدة، ونتغلّب على هذا من خلال تهيئة النّموذج الخاصّ بنا مع نماذج أخرى مدرّبه مسبقًا (Brown et al., 2020; Chen et al., 2021) أخيرًا، نجد أنّه من الأهمّيّة استخدام دفعة كبيرة تكفي لتحقيق الأداء الأمثل. فيما يلي توضيح أنّ هذه الوصفة البسيطة التي تجمع بين تهيئة النّموذج المدرّب مسبقًا والتّعلّم المتباين الضّخم والتّدريب على نطاق واسع، وبإمكانها أن تنتج نصوصًا وتعليمات برمجيّة تمتلك نطاقًا واسعًا من القدرات. نقوم بتدريب سلسلة من نماذج تضمين النّصّ غير الخاضعة للرّقابة (cpt-text) بأحجام مختلفة تتراوح من175B-300M من االمعاملات ومراقبة التّحسُّن المستمر مع زيادة أحجام النّموذج. (الشّكل-1)

فيما يتعلّق بدقّة التّصنيف، يتمّ حساب المتوسّط عبر 7 مهام في التّصنيف الخطّيّ المباشر كما هو موضّح في SentEnce (Conneau & Kiela,2018)، يتمّ استخدام هذا التّصنيف لقياس جودة التّضمينات (التّمثيلات) النّصيّة التي تمّ إنشاؤها باستخدام نماذج التّعلّم العميق ((يتمّ تدريب نماذج التّضمين باستخدام مجموعة واسعة من البيانات النّصيّة لفهم وتمثيل المعنى والمضمون اللّغويّ، وبعد ذلك يتمّ استخدام هذه التّضمينات في مهام مختلفة مثل التّصنيف النّصيّ، التّرجمة الآليّة، استخراج المعلومات وغيره. تتطلّب هذه المهمّة توفّر مجموعة بيانات تتضمّن أمثلة مصنّفة بشكل واضح؛ حيث يعرف تصنيف كلّ مثال في المجموعة، ويتمّ تقييم أداء التّصنيف الخطّيّ عن طريق قياس مدى توافق تصنيف النّموذج مع التّصنيف الصّحيح))

يحقّق النّموذج غير الخاضع للإشراف الخاصّ بنا نتائج جديدة مع تحسّن نسبيّ بنسبة 4٪ و 1.8٪ مقارنة مع النّماذج السّابقة سواء الخاضعة للإشراف او غير الخاضعة للإشرافGiorgi et al.2021) ، (2020Gao et al على التّوالي. ركّز العمل السّابق على تضمين النّصّ في مجالات مختلفة، مع وجود اختلافات في البيانات وأهداف التّدريب وبنية النّموذج. ظهر موضوعان بحثيّان رئيسيّان؛ تضمين الجملة sentence embedding واسترجاع المعلومات العصبية neural information retrieval، يهدف تضمين الجملة إلى إنشاء تمثيلات عالية الجودة للجمل الفرديّة، بينما يركّز استرجاع المعلومات العصبيّة على تمثيلات نصّ التّعلّم المناسبة لمهام البحث والاسترجاع. على الرّغم من هدفهم المشترك المتمثّل في تعلّم تمثيلات نصّيّة عالية الجودة، فقد تمّ تقييم هذه المجالات على أساس معايير مميّزة واعتبارها موضوعات بحثيّة منفصلة. ومع ذلك، نجد أنّ نفس النّموذج الذي يحقّق أداءً جيّدًا على مقاييس تضمين الجمل كما تمّ مناقشته أعلاه، يمكنه أيضًا تحقيق نتائج مثيرة للإعجاب في استرجاع المعلومات على نطاق واسع، عند تقييمها في مهمّة تصنيف ترتيب فقرات MSMARCO (Nguyen et al., 2016) وذلك للبحث في أكثر من 4 ملايين فقرة، تحقّق نماذج CPT-Text تحسينًا نسبيًّا بنسبة 23.4% مقارنة بالأساليب غير الخاضعة للإشراف عليها السّابقة الأفضل (Robertson, 2009).. في مهمّة البحث في 21 مليون مستند من ويكيبيديا، يحقّق نموذج CPT-Text تحسينًا نسبيًّا بنسبة 14.7% و10.6% على التّوالي مقارنةً بالأساليب غير الخاضعة للإشراف عليها (Izacard et al., 2021) لـ Natural Questions (Kwiatkowski et al., 2019) و TriviaQA (Joshi et al., 2017). وفي مهمّة TriviaQA تكون طريقتنا غير الخاضعة للإشراف تنافسيّة مع النّماذج المعايرة بشكل جيّد، بعد ذلك نقوم بتدريب نماذج تضمين الشّفرة (CPT-Code) باستخدام نفس الطّريقة. تعلم نماذجنا عبر أزواج (نصّ، شفرة) المستخرجة من الشّفرة المفتوحة، نقوم بتقييم نموذجنا علىCode SearchNet (Husain et al 2020)، وهو مقياس بحث الشّفرة المستخدم على نطاق واسع، حيث يتعيّن العثور على مقتطف الشّفرة الأكثر صلة بناءً على استعلام اللّغة الطّبيعيّة.

تحقّق نماذجنا نتائج جديدة متقدّمة بنسبة 20.8% مقارنةً بأفضل نتيجة سابقة (Guo et al., 2021). على عكس نماذج تضمين النّصوص، لاحظنا عدم تحسين الأداء في البحث عن الشّفرة عند زيادة عدد المعاملات في CPT-Code من 300 مليون إلى 1.2 مليار. أخيرًا نقوم بتجربة تعديل نماذجنا عن طريق ضبطها بشكل متقن على العديد من مجموعات البيانات المشرف عليها، وندرس أداء التّعلم النّقليّ أو التّحوليّ. عندما يتمّ تعديلها بشكل متقن على مجموعات بيانات الاستدلال اللّغويّ الطّبيعيّ (Natural Language Inference (NLI، نرى زيادة إضافيّة في التّصنيف باستخدام اختبار خطّيّ، حيث تفوّق الأداء الأفضل السّابق لطريقة التّعلّم النّقليّة (Gao et al., 2021) بنسبة 2.2%. في مهمّة تصنيف المشاعر SST-2 Socher et al, 2013)، نجد أنّ تمثيلاتنا الوصفيّة كافية بما فيه الكفاية حتى أنّ النّمط القريب k-NN يحقّق نتائج مقارنة بتصنيف الاختبار الخطّيّ. بشكل مثير للاهتمام، يتفوق الأداء غير المدعوم بالتضمينات (Zero-shot) على النماذج المشرف عليها للشبكات العصبية التي تم تقديمها مع إصدار مجموعة بيانات SST-2. نحن أيضًا نعمل على تعديل النّموذج غير المشرف عليه على مجموعة بيانات MSMARCO ونقوم بتقييمه على مجموعة من المهام غير المدعومة بالتّدريب في اختبار BEIR (Thakur et al., 2021) للبحث.

في سياق التّحويل transfer، تحقّق نماذجنا تحسينًا نسبيًّا بنسبة 5.2% مقارنةً بالأساليب السّابقة (Izacard et al., 2021)، وتكون مقارنة حتى مع الأساليب (Santhanam et al., 2021؛ Formal et al., 2021؛ Wang et al., 2020) التي تتطلّب حسابات أكبر بشكل كبير أثناء الاختبار.

2. المنهجيّة

يتمّ تدريب النّماذج الواردة في النّصّ المقدّم بهدف تباين على البيانات المقترنة، تتكوّن مجموعة التّدريب من عيّنات مقترنة، {(xi ، yi)} N i = 1 ، حيث (xi ، yi) تقابل زوج مثال إيجابي، ممّا يشير إلى أنّ xi و yi زوجين متشابهين لغويًّا أو ذات صلة بسياق النّص.

1.2. النّموذج

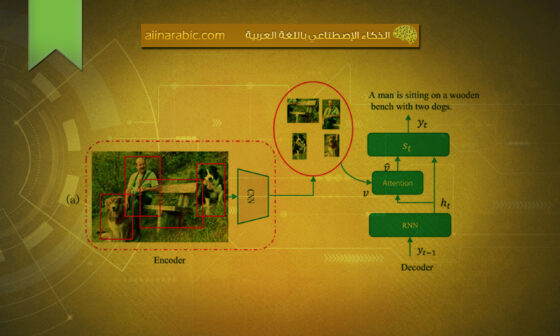

بفرض إعطاء زوجين للتّدريب؛ وهما(x,y) يقوم المُشفّر بتحويل تسلسلات الإدخال إلى تمثيلات أو تضمينات متّجهيّة كثيفة، وللدّلالة على بداية ونهاية تسلسل الإدخال، يتمّ إدراج رموز tokens خاصّة للتّمييز، وهي [SOS] و [EOS] على التّوالي في بداية ونهاية التّسلسل. يتمّ استخراج الحالة المخفيّة من آخر طبقة تتوافق مع الرّمز الخاصّ [EOS] وتعتبر كتضمين لتسلسل الإدخال، [SOS] و [EOS] هما محدّدات رمزيّة خاصّة مستخدمة في مشفّر المحوّلات لتحديد بداية ونهاية تسلسل الإدخال على التّوالي، يتمّ إدراجها في بداية ونهاية تسلسل الإدخال لتوفير سياق وبنية النّموذج أثناء المعالجة كما هو واضح في الشكل (2).

في الشّكل 2 يقوم المشفّر E بمُقابلة المدخل x إلى vx التّضمين. لتوفير السّياق والبنية يتمّ إلحاق الرّموز المميّزة [SOS] و [EOS] ببداية تسلسل الإدخال ونهايته على التوالي، يتمّ بعد ذلك استخراج الحالة المخفيّة للطّبقة الأخيرة المقابلة للرّمز المميّز [EOS] واعتبارها دمجًا لتسلسل الإدخال.

في الشّكل 3 أعلاه، يقوم المشفّر E بمُقابلة المدخلات x وy مع التضمينات vx و vy بشكل مستقلّ، (التّضمينات vx وvy عبارة عن تمثيلات متّجهيّ كثيفة لمتواليات الإدخال x وy على التّوالي)، يتمّ بعد ذلك تعريف درجة التّشابه بين x وy على أنّها تشابه جيب التّمام cosine similarity بين متّجهي التّضمين هذين. تشابه جيب التّمام هو مقياس للتّشابه بين متّجهين غير صفريّين لمساحة المنتج الدّاخلية التي تقيس جيب التّمام للزّاوية بينهما، في هذه الحالة يُحسب تشابه جيب التّمام بين التّضمينات vx وvy على أنّه حاصل الضّرب النّقطيّ للمتّجهين مقسومًا على حاصل ضرب مقاديرهما.

تُستخدم درجة التّشابه هذه كمقياس لمدى تشابه المدخلات المتسلسله x وy من النّاحية اللّغويّة أو ذات الصّلة بالسّياق، في المحوّل التّشفيريّ يتمّ تعيين تسلسل الإدخال x وy إلى المتضمّنات vx وvy على التّوالي، هذه المتضمنات عبارة عن تمثيلات متّجهيّة كثيفة تلتقط المعلومات الدّلاليّة للمدخلات المتسلسله. يعالج مشفّر المحوّلات المدخلات المتسلسله بشكل مستقلّ ويولّد االازواج او الانماط المقابلة، لتقدير التّشابه بين مدخلين x وy، يُحسب تشابه جيب التّمام بين االازواج او الانماط، vx وvy، تشابه جيب التّمام هو مقياس للتّشابه بين متّجهين يحسب جيب تمام الزّاوية بينهما، يتمّ حسابه بأخذ حاصل الضّرب النّقطيّ للمتّجهين وقسمته على حاصل ضرب مقاديرهما كما هو مُبيّن في الشكل (4)، من خلال حساب تشابه جيب التّمام بين vx وvy، نحصل على درجة تشابه تشير إلى مدى تشابه أو ارتباط تسلسل الإدخال x وy من حيث المحتوى الدّلالي، يمكن استخدام درجة التّشابه هذه لمقارنة وتقييم التّشابه أو الصّلة بين أزواج المدخلات المختلفة.

في سياق معيّن تمثّل العمليّة ⊕ سلسلة من سلسلتين معًا؛ هي عمليّة لربط سلسلتين معًا يتمّ استخدامها لدمج عناصر أو رموز مختلفة لتشكيل سلسلة واحدة. فيما يتعلّق باختيار المتسلسلات، يذكر النّصّ أنّ استخدام متسلسلات مختلفة يمكن أن يؤدّي إلى تدريب أكثر استقرارًا، على وجه التّحديد بالنّسبة للمدخلات المتسلسله x، يتمّ استخدام المتسلسله “[” كـ [SOS[ x (بداية التّسلسل) و “]” كما يتمّ استخدام [EOS[ x (نهاية التّسلسل)، تتمّ إضافة هذه المتسلسلات إلى تسلسل الإدخال x لتوفير السّياق والبنية، وبالمثل بالنّسبة للمدخلات المتسلسله y، يتمّ استخدام المتسلسلات “f” و “g” كـ [SOS[ y و [EOS[ y على التّوالي. يتمّ إلحاق هذه ا المتسلسلات بالمدخلات المتسلسله y للإشارة إلى بداية التّسلسل ونهايته.

2.2. هدف التّدريب

يتضمّن هدف تدريب النّماذج في هذا العمل مقارنة العيّنات المزدوجة في مجموعة التّدريب مع الأمثلة السّلبيّة في العيّنة، يعتمد هذا النّهج على عمل Yih et al. (2011) (2016). التّعلّم المقارن مع الأمثلة السّلبيّة دفعة واحدة هو أسلوب مستخدَم على نطاق واسع في نماذج التّدريب، يتضمّن إنشاء أمثلة سلبيّة داخل نفس مجموعة بيانات التّدريب، تُستخدم هذه الأمثلة السّلبية للتّناقض مع الأمثلة الإيجابيّة (العيّنات المزدوجة) وتساعد النّموذج على تعلّم التّمييز بينها. من خلال مقارنة الأمثلة الإيجابيّة بالسّلبية دفعة واحدة، يتمّ تشجيع النّموذج على تعلّم التّمثيلات التي يمكنها التّمييز بشكل فعّال بين الأمثلة المتشابهة والمختلفة.

يصف النّصّ المعطى استخدام الأمثلة السّلبيّة دفعة واحدة لتعلّم التّباين في تعلّم التّمثيل غير الخاضع للإشراف، تمّ استخدام هذا النّهج على نطاق واسع في الأعمال السّابقة، بما في ذلك Radford et al. (2021)، Jia et al. (2021), et al. (2020), and Isacard et al. (2021).

في هذا النّهج لكلّ مثال في مجموعة مصغّرة من أمثلة M، يتمّ استخدام الأمثلة الأخرى (M-1) في العيّنة كأمثلة سلبيّة، هذا يعني أنّ كلّ مثال يتناقض مع جميع الأمثلة الأخرى في نفس العيّنة بما في ذلك نفسه كمثال سلبيّ، يتيح استخدام الأمثلة السّلبيّة دفعة واحدة من خلال إعادة استخدام الحساب في كلّ من التّمرير الأماميّ والخلفيّ، ممّا يجعل عمليّة التّدريب عالية الكفاءة، وذلك لأنّه يمكن استخدام نفس الحسابات لحساب درجات التّشابه بين كلّ مثال وجميع الأمثلة الأخرى في العيّنة. يتم تمثيل خرج النموذج لدفعة واحدة هي مصفوفة M x M، حيث يتمّ يُمثَّل كلّ سجل إدخال (xi، yj) من خلال درجة تشابه بين عمليّات تضمين المتسلسلات xi و yj.

يتم استخدام معامل درجة الحرارة لحساب السجلات لمجموعة من الأمثلة. تعتبر المدخلات الموجودة على قطريّ المصفوفة أمثلة إيجابيّة فقط. بشكل عام يتيح استخدام الأمثلة السّلبيّة دفعة واحدة لتعلّم التّباين والتّدريب الفعّال لنماذج التّعلم التمثيليّ غير الخاضع للإشراف، من خلال مقارنة كلّ مثال مع جميع الأمثلة الأخرى في نفس العيّنة، يمكن للنّموذج أن يتعلّم التّمييز بين الأمثلة المتشابهة وغير المتشابهة وتعلّم التّمثيلات المفيدة للمهام النهائيّة، في سياق المعلومات المقدّمة، من المحتمل أن يتمّ حساب خسائر الإنتروبيا المتقاطعة cross entropy losses في اتجاهات الصف والعمود بناءً على مصفوفة السّجلات. مصفوفة اللّوغاريتمات عبارة عن مصفوفة M x M، حيث يمثّل كلّ سجل دخول (xi ، yj) درجة التّشابه بين عمليّات تضمين تسلسل الإدخال xi و yj. لحساب خسارة الإنتروبيا المتقاطعة؛ تتمّ مقارنة الاحتمالات المُتوقّعة (التي تمّ الحصول عليها من خلال تطبيق دالة سوفت-ماكس SoftMax على السّجلات) والتسميات الحقيقيّة، يتمّ حساب الخسارة لكلّ صفّ وعمود على حدة، ثمّ يتمّ جمع الخسائر من كلا الاتجاهين للحصول على خسارة التدريب النهائيّة، في حين لا يتمّ توفير الشفرة الزّائفة ذات النمط المقسم المحدّد، كما هو موضح في الكود الرمزيّ التالي:

3. النّتائج

باستخدام نماذج اللغة التوليديّة المدرّبة مسبقًا ستتمّ تهيئة نماذج cpt-tex باستخدام Generative Pre-trained Transformers (GPT)، ويتمّ تهيئة cpt-code باستخدام بيانات التدريب الموجودة في (Codex Chen et al. 2021) وذلك باستخدام بيانات التّدريب الخاضعة للإشراف . وتوجد في قاعدة للبيانات وتسمّى NLI datasets؛ وهي مجموعات البيانات المتعلقة باستدلال اللغة الطبيعيّة وتوجد فيها أمثله سلبية صريحة جنبًا إلى جنب مع الأمثلة السلبيّة الأخرى، نقوم بتقييم نماذج تضمين النّص الخاصة بنا في مجموعة واسعة من المهام: التصنيف الخطيّ، وتشابه الجملة، والبحث الدلاليّ. أثناء تضمين الجملة (Reimers & Gurevych، 2019؛ Gao et al.، 2021؛ Giorgi et al.، 2020) بما أنّ الأساليب السابقة في مجال تضمين الجملة واسترجاع المعلومات العصبيّة عادةً ما تُبلغ عن النّتائج فقط في مهام معياريّة محدّدة، مثل تضمين معايير أو معايير بحث على التوالي.

1.3. تضمينات النّصوص Text Embedding

يُستخدم مقياس SentEval(Conneau & Kiela, 2018) على نطاق واسع لتقييم جودة تضمين النّصوص، ويتضمّن مجموعة شاملة من المهام المتنوّعة في تصنيف الاستعلامات الخطيّة ومشابهة الجمل، نقوم بالاستفادة من نفس هذا المقياس لتقييم جودة تضمين النّصوص الخاصّة بنا، يتيح هذا المقياس لنا فهمًا شاملًا لقدرة نموذجنا على تمثيل الجمل بشكل دقيق وفعّال في مجموعة واسعة من المهام، مما يساعدنا على تقييم أداء النّموذج ومقارنته مع الأساليب السابقة في مجال تضمين النّصوص.

1.1.3. تصنيف التّحقيق الخطيّ

عند تقييم التصنيف الخطيّ، يتمّ استخدام التضمينات كميزات لتدريب مصنف خطيّ لحلّ مجموعة متنوّعة من المهام التابعة. تظهر النتائج في الجدول 2 (موجود ضمن ملحق خاص بالجداول أسفل الورقة البحثية) كميزة واضحة لاستخدام أحجام نماذج أكبر في إنتاج ميزات أفضل لتحسين أداء التّصنيف، ببساطة يعني ذلك أنّه عند استخدام نماذج أكبر الحجم، يتمّ إنتاج ميزات أفضل تساعد في تحسين أداء التّصنيف، تلك الميزات تُستخدم لتدريب مصنف خطيّ لحلّ مهام أخرى مثل التّصنيف النصيّ ومشابهة الجمل وغيرها من المهام التابعة، هذا يدلّ على أنّ حجم النموذج له تأثير إيجابيّ على جودة الميزات المستخدمة في التّصنيف، ويساهم في تحسين أداء التصنيف بشكل عام. في إطار التّعلّم التنقليّ، نقوم بضبط نماذج التشفير النصيّ غير الخاضعة للإشراف وهي (cpt-text models) على مجموعات البيانات SNLI (Bowman et al., 2015) و MNLI (Williams et al., 2018). يتمّ استخدام أزواج الاستدلال (entailment) كأمثلة إيجابيّة وأزواج التناقض (contradiction) كأمثلة سلبيّة، يتمّ تعديل نماذج التشفير النصيّ غير الخاضع للإشراف لتتأقلم وفقًا لمتطلبات المهام المحدّدة في تلك البيانات. بغضّ النظر عن إعدادات التّعلّم غير الخاضع للإشراف أو التّعلّم التنقليّ، فقد تمّ تحقيق نتائج حديثة للتكنولوجيا في هذا المجال، وهذا يعني أنّ نماذج التشفير النصيّ التي تمّ ضبطها بناءً على النماذج غير الخاضعة للإشراف تظهر أداءً متميزًا في المهام التي تتطلب استدلالات وتناقضات، وقد تمّ تحقيق نتائج متقدّمة في هذين الإعدادين؛ التّعلّم غير الخاضع للإشراف والتّعلّم التنقليّ، ونجد أنّ هناك إشارة إلى فعاليّة النماذج في توليد تمثيلات نصية عالية الجودة وتحسين أداء التصنيف والتحليل الدّلاليّ.

2.1.3. تصنيف اللقطة الصفريّة zero shot classification و الجيران الأقرب k-NN

يتعلق التصنيف الصفريّ بالقدرة على تصنيف البيانات إلى فئات غير معروفة مسبقًا دون الحاجة إلى تدريب مسبق على تلك الفئات، في حالة مهمة تصنيف المشاعر الثنائيّة SST-2 يعني ذلك القدرة على تصنيف النصوص إلى فئات إيجابيّة أو سلبيّة دون الحاجة إلى تدريب مسبق على مجموعة البيانات المحدّدة لهذه المهمة، هذا النهج يسمح بتصنيف النصوص بناءً على الشبه الدلاليّ بينها وبين نصوص التدريب، مما يمكّنه من التصنيف حتى في حالة عدم توفر بيانات التدريب المباشرة لمهمّة التصنيف المحدّدة. في هذه الدّراسة قمنا بتجربة باستخدام نموذج 6B (L) cpt-text المدرّب مسبقًا، والذي تمّ ضبطه مرّة أخرى باستخدام بيانات NLI. في التجربة الصفريّة الأولى يتمّ تعيين كلّ نص مدخل بإحدى العلامتين (‘إيجابيّ’، ‘سلبيّ’) استنادًا إلى إحدى العلامتين ومن لديه تضمينه الأقرب إلى تضمين النصّ المدخل. في هذا السياق يتمّ استخدام تضمين النصّ (نسخة مشفرة ضمن النموذج) لتمثيل النصوص وقيمها في مساحة الفضاء، يتمّ حساب المسافة بين تضمين النصّ المدخل وتضمين كلّ علامة (‘إيجابيّ’، ‘سلبيّ’)، ومن ثمّ يتمّ تعيين النصّ بالعلامة التي لديها التّضمين الأقرب. هذا النهج يسمح لنا بتصنيف النصوص بناءً على التشابه الدلاليّ بينها وبين تضمينات العلامات المحدّدة مسبقًا، مما يمكننا من تحقيق التصنيف حتى في حالة عدم توفر بيانات التدريب المباشرة للمهمة الخاصة بهذه العلامات. يمكن تحسين الأداء بشكل أكبر من خلال استخدام الإشارات، حيث نستخدم وصفًا بسيطًا للعلامة مثل “هذا مثال على تقييم إيجابيّ/سلبيّ لفيلم” بدلاً من كلمة واحدة. يعتبر استخدام التضمينات بهذا الشكل في التصنيف الصفريّ نوعًا جديدًا مقارنةً بالأبحاث السابقة في مجال التضمينات، ومن المثير للاهتمام أنّ نتائجنا في التصنيف الصفريّ أفضل من نتائج الشبكات العصبية المدرّبة الخاضعة للإشراف التي تمّ تقديمها مع إصدار مجموعة البيانات Socher et al.، 2013). في تجربة تصنيف الجيران الأقرب k-NN عندما يتمّ إعطاء نصّ كمدخل، يتمّ التنبؤ بالتصنيف الذي يحظى بأكبر تواجد بين 256 من امثلة التدريب وذلك حتى يتمّ التقرّب أكثر إلى النصّ المدخل في مجال التضمين. وكما هو موضح في الجدول 3، فإنّ مصنف الجيران الأقرب k-NN _بدون ضبط أيّ من المُعاملات القابلة للتدريب_ يحقق نتائج مماثلة للمصنف الخطيّ.

3.1.3. تشابُه الجُّمل Sentence Similarity

نجد أنّ نماذجنا تحقق أداء أسوأ على مجموعة البيانات SentEval، من الطرق الحاليّة المتقدّمة السابقة (الجدول 4). مهمّة تشابه الجُّمل هي مهمة ثابتة ومحدّدة تمامًا (على سبيل المثال، هل الجّملتان “جاك يحب جيل” و”ماري تحب الشوكولاتة” هل متشابهتان؟)، يُقدّم Goodman (1972) حُجّة بأنه يمكن أن يكون هناك تشابه أو اختلاف لا نهائيّ بين كلّ جملتين Vervaeke et al.، 2012. توجد تفسيرات محتملة لسبب أداء نماذجنا بشكل أفضل من الأعمال السابقة، من خلال مهامّ البحث والتصنيف ولكن ليس في هذه المهمة الخاصة بالجُّمل، ويعود ذلك إلى أنّ هذه النماذج لا تكون مُحسّنة بشكل كافٍ للتعرّف على كلّ المقاييس الخاصة بتشابه الجمل، من المهمّ أن نلاحظ أنّ الأساليب السابقة للبحث في التضمينات لا تقدّم تقارير حول أداء مهامّ تشابه الجُّمل (Karpukhin et al.، 2020a؛ Sachan et al.، 2021؛ Izacard et al.، 2021). يتمّ تقديم المزيد من النقاش حول هذه الظّاهرة في القسم.

2.3. البحث عن النصوص Text Search

في الأبحاث السابقة يناقش الباحثون الأعمال السابقة المتعلّقة بتدريب طرق التّضمين للبحث، يلاحظ الباحثون أنّ مثل هذه الطرق عادةً تتطلب ضبطًا دقيقًا على مجموعة بيانات محدّدة للبحث في النصوص، وغالبًا ما تشتمل على إعداد متعدّد الخطوات حيث تعتمد النماذج المضبوطة بدقّة على ترميز تقاطع الاستعلام query والمستند document؛ الذي يتطلب استخدام محوّل تراكب التركيز الباهظ التكلفة في الخطوة النهائيّة، وعلى النقيض من ذلك يهدف الباحثون الذين كتبوا الوثيقة إلى دفع حدود استخدام نموذج تضمين واحد للبحث الدلاليّ على نطاق واسع؛ وهذا يعني أنّ نهجهم لا يتطلب ضبطًا دقيقًا على مجموعة بيانات محدّدة أو إعداد متعدّد الخطوات المعقد، بدلاً من ذلك يستخدمون نموذجًا غير مراقب يتمّ تدريبه على بيانات مقترنة تحدث طبيعيًا لتحقيق أداء جيد في مهامّ البحث الدلاليّ على نطاق واسع، وبذلك يهدفون إلى إظهار فعاليّة وكفاءة نهجهم في تعلّم تمثيلات النص ذات الجودة العالية لمهامّ البحث.

1.2.3. البحث على نطاق أوسع Large-Scale Search

في المعلومات المقدّمة، يناقش الباحثون تقييم نماذجهم على عدّة مقاييس بحث نصيّة على نطاق واسع. يشير الباحثون إلى أنّ البحث في قاعدة بيانات MSMARCO يتطلب من النموذج البحث في أكثر من 4 ملايين مستند، بينما يصل ذلك إلى أكثر من 21 مليون مستند ويكيبيديا في قاعدتي البيانات Natural Questions و TriviaQA. من أجل بناء فهارس المُتّجهات النصيّة للبحث التقريبيّ بواسطة خوارزميّة الجيران الأقرب؛ يستخدم الباحثون مكتبة FAISS من فيسبوك، ويلاحظ الباحثون أنّ نفس النموذج غير الخاضع للإشراف الذي تمّ مناقشته سابقًا، يحقق أداء مثيرًا للإعجاب في البحث الدلاليّ. يشير الباحثون في الجدول 5 أنّ نهجهم cpt-text، يفوق النهج غير المراقب السابق بفارق كبير، وأنّ حجم النموذج الأكبر يؤدّي بشكل متّسق إلى تحسين الأداء، كما يشير الباحثون إلى أنّ نموذجهم غير المراقب يتنافس حتى مع النماذج المضّبوطة بدقة في مقياس TriviaQA. بشكل عام يهدف الباحثون إلى إظهار فعاليّة نهجهم في تحقيق أداء عالٍ في مهامّ البحث على نطاق واسع، دون الحاجة لضبط دقيق fine-tune أو إعدادات متعدّدة الخطوات المعقدة، يتنافس نموذجنا حتى مع النّماذج المضبوطة بدقة بشكل مدهش على مقياس TriviaQA.

2.2.3 بحث المقارنة المعياريّة للفهرسة والاسترجاع BEIR

تمّ تقييم نماذج البحث التي طوّرها الباحثون على 11 مهمة بحث مختلفة ضمن مجموعة التقييم BEIR (Thakur et al., 2021)، يتمّ مقارنة أداء نموذجهم غير المراقب مع أساليب تضمين البيانات السابقة التي تستخدم بيانات MSMARCO المضبوطة بالاشتراك، ويتبين أنّ نموذجهم يحقق أداءً تنافسيًّا كما يتمّ مقارنة أداء نموذجهم مع نموذج BM25 المعتمد على الكلمات الافتتاحيه وتظهر النتائج أنّ BM25 يحقق أفضل النتائج في التدريب غير الخاضعة للإشراف، بينما يحقق نموذجهم المعروف باسم “cpt-text” أفضل النتائج في نقل المعرفة (transfer learning)، ومع ذلك لم يقدّم الباحثون مزيدًا من التفاصيل حول المهامّ الفردية أو نتائج التقييم في هذا القسم. إذا كنت ترغب في مزيد من المعلومات حول تقييم نموذج “cpt-text” على مهام البحث في BEIR، يمكنك الاطلاع على الجدول رقم 5 والنصوص 2 و3. أبلغ المؤلفون عن أداء نهجهم “cpt-text” في إعداد النقل، ووجدوا أنّ نماذجهم تحقق تحسنًا نسبيًّا بنسبة 5.2٪ مقارنة بأفضل طريقة تّضمين سابقة (Izacard et al.، 2021)، كما لاحظوا أنّ أسلوبهم يتفوّق في الأداء على طريقة أخرى تسمى “docT5query” (Nogueira et al.، 2019a)، والتي تعتمد على نموذج T5 (المُعاد ضبطه لتوسيع المستند document expansion) . يوضح المؤلفون كذلك أنّ نهجهم تنافسيّ حتى مع الأساليب التي تستخدم قدرًا أكبر من الحوسبة في وقت الاختبار، على سبيل المثال ذكروا طريقة تسمى “BM25 + CE” (Wang et al.، 2020)، والتي تستخدم البحث بالكلمات الافتتاحيه لتحديد أفضل 100 مستند ثمّ إعادة ترتيبها باستخدام مُشفّر شبكة عصبونيّة متعدّدة الانتباه. attention neural network encoder.

كما تمت ملاحظة أنّ شبكة ترتيب التشفيرthe ranking encoder network المستخدمة في هذه الطريقة (طريقة “BM25+CE”) تقوم بعمليّة حسابيّة مكلفة للتركيز المشترك بين الاستعلام والاهتمام بالوثيقة، مما يجعل من الصعب استغلال الفهرسة وخوارزميّات البحث التقريبيّ للحصول على بحث سريع وفعال في وقت الاستعلام، كما يذكرون أنّ هناك العديد من الأعمال السابقة التي تتبنى نهجًا مماثلًا للاستفادة من مزيد من موارد الحساب في وقت الاستعلام لتحقيق أداء بحث أفضل. يصف الكتاب طريقتين أخريتين لاسترجاع المعلومات: ColBERT v2. وهي طريقة متعدّدة المتجهات تُمثّل الاستعلام والوثائق كمجموعة من المتجهات، وتستخدم إجراء استرجاع متعدّد الخطوات للحصول على الوثائق ذات الصلة. بالمقابل تٌمثّل الطريقة الثانية Splade v2 الاستعلامات والوثائق على شكل متجهات فارغة ذات حجم يعادل مفردات مُشفّر BERT، وعلى العكس من ذلك تقوم الطريقة المعتمدة من قبل “cpt-text”، بحساب تضمين واحد كثيف لكلّ وثيقة فقط، والذي يتمّ فهرسته بشكل غير متصل بالشبكة ولا يعتمد على أيّ عمليّة من إعادة ترتيب المشاهدة في وقت الاستعلام.

3.3. البحث عن التعليمات البرمجيّة Code Search

ثمّ يتناول الباحثون تقييم نماذج تضمين الشيفرة البرمجيّة الخاصة بهم في مهمة البحث في الشيفرة البرمجيّة باستخدام مجموعة بيانات CodeSearchNet، في هذه المهمة يتمّ إعطاء النموذج استعلامًا باللغة الطبيعيّة ويتوقع منه استرداد كتلة الشيفرة البرمجيّة ذات الصلة من بين 1,000 خيار، من المتوقع أن يقوم النموذج بإرجاع كتلة الشيفرة البرمجيّة ذات الصلة من بين 1,000 مرشح. يتمّ تقييم النماذج على 6 لغات برمجة ويحقق نموذجنا نتائج على أعلى مستوى (الجدول 7)، على عكس التضمينات النصيّة لا نرى تحسينًا في الأداء مع زيادة حجم النموذج للتضمينات الخاصة بالشيفرة البرمجيّة، في هذا الجزء يصف الباحثون تقييم نماذجهم على مهمة أكثر تحديًا للعثور على كتلة الشيفرة البرمجيّة ذات الصلة بين 10,000 مرشح بدلًا من 1,000، يقارنون أداء نماذجهم cpt-text بنماذج cpt-code في الجدول 8. يلاحظ الباحثون أنّ تضمينات النصّ تؤدّي بشكل جيد نسبيًا في البحث في الشيفرة البرمجيّة؛ خاصة في لغة البرمجة بايثون Python ومع ذلك يرون تراجعًا في أداء نماذج تضمين الشيفرة البرمجيّة مع زيادة عدد الخيارات المشتتة، ولا يرون أنّ النماذج ذات الحجم الأكبر تعزّز من أداء البحث.

4.3. التحليل

1.4.3. تأثير حجم الدّفعة

في هذا القسم، يقوم الباحثون بتحليل تأثير حجم الدّفعة batch size على أداء نموذجهم، فيجرون دراسة تجريبيّة ويقارنون أداء نموذجهم cpt-text بحجم S (300M)؛ والذي تمّ تدريبه باستخدام أحجام دفعات مختلفة على مجموعة التطوير NQ. يوضح الباحثون أنه نظرًا لأنهم يقومون بتدريب النموذج بمعاملات سلبيّة داخل الدّفعة، فإنّ زيادة حجم الدّفعة يزيد من احتماليّة وجود معاملات سلبيّة صعبة hard negatives في الدّفعة، مما يؤدٌي إلى تحسين أداء النموذج بشكل كبير. يمكن العثور على النتائج والتفاصيل الدّقيقة في الجدول 9.

2.4.3. سلوك التدريب

ومن ثمّ تتمّ مناقشة سلوك تدريب النماذج حيث يلاحظ أنه مع تدريب النماذج لفترة أطول، يزداد أداء المهام المتعلقة بالبحث والتصنيف بينما ينخفض أداء مهامّ تشابه الجمل، كما هو موضّح في الشكل رقم 5. يقترح الكتاب أنّ هذا قد يكون بسبب عدم تحديد واضح لمهمة تشابه الجمل، وأنّ مهامّ البحث ومهامّ تشابه الجمل قد تحتوي على تعارض في التعريفات. على سبيل المثال، يمكن اعتبار جملة ونفيها ذات صلة خلال البحث، ولكنها ليست “مشابهة” في مهامّ تشابه الجمل. يشير البحث أيضًا إلى أنّ الأساليب السابقة للبحث في التضمينات لا تقدّم نتائج أداء لمهامّ تشابه الجمل، وأنّ الأساليب السابقة لتضمين الجمل لا تقيّم أداءها في مهامّ البحث، ومن ثمّ تشير المقالة إلى أنّ الأساليب السابقة للبحث في التضمينات لا تقدّم نتائج أداء لمهامّ تشابه الجمل، وأنّ الأساليب السابقة لتضمين الجمل لا تقيّم أداءها في مهامّ البحث. كما توضح المقالة أيضًا أنه عند اتخاذ قرار بشأن المحطات النموذجيّة _(ختيار نقاط الفحص التي ستُستخدم للتقييم) مما يعني اختيار إصدارات محفوظة محدّدة من النموذج لتقييم أدائه على مهام مختلفة التي ستستخدم للتقييم؛ لقد قاموا بإعطاء أهميّة أعلى لمهامّ البحث والتصنيف لأنها غالبًا ما ترتبط بتطبيقات واقعيّة محدّدة بوضوح، بينما مهامّ تشابه الجمل ذات أهميّة أقلّ في هذا الصدد.

4. الأعمال ذات الصلة

تناقش المقالة الأعمال ذات الصلة في الهدف من تمثيل التّعلّم، وهو تعلّم فضاء تضمين حيث تكون الأمثلة المماثلة قريبة من بعضها والأمثلة غير المماثلة بعيدة عن بعضها. يعتبر التّعلّم التباينيّ إجراءً تعليميًا يصيغ المهمة التعليمية كمشكلة تصنيف باستخدام مرشحات مماثلة وغير مماثلة. اعتمدت الأبحاث السابقة على أهداف التباين لتعلّم التمثيل للصور والنصوص، على حدّ سواء. وقد تمّ ذكر العديد من المراجع التي استخدمت التّعلّم التباينيّ لتمثيل التّعلّم في الصور والنصوص، بما في ذلك Wu et al. (2018)، He et al. (2020)، Chen et al. (2020)، Zbontar et al. (2021)، Lu et al. (2019)، Sun et al. (2019)، Kim et al. (2021)، وRadford et al. (المرجع غير مكتمل في النص المعطى). ومن ثمّ يتمّ النقاش في مجال البحث في تعلّم تضمين الكلمات والتمثيلات ذات الأبعاد المنخفضة لقطع النص الأكبر، تمّ دراسة تعلّم تضمين الكلمات بشكل واسع، مع الإشارة إلى Brown et al. (1992) ، Gutmann & Hyvärinen (2010) ، Mikolov et al. (2013، و Pennington et al. (2014). تمت دراسة تعلّم التمثيلات ذات الأبعاد المنخفضة لقطع النص الأكبر أيضًا بشكل واسع، مع الإشارة إلى Deerwester et al(1990) وYih et al. 2011). يذكرون فيها أنّ معظم النماذج الحديثة لتعلّم تضمين الجمل تعتمد على مجموعات بيانات استنتاج اللغة الطبيعيّة (NLI) الخاضعة للإشراف، باستخدام أزواج التوجيه كأمثلة إيجابيّة وأزواج التناقض كأمثلة سلبيّة صعبة. يشيرون أيضًا إلى SBERT Reimers & Gurevych, 2019)، الذي قام بتدريب شبكة سياميّة siamese network (شبكة سياميّة هي نوع من الشبكات العصبيّة تتكوّن من تكرار شبكتين فرعيتين متطابقتين تشتركان في نفس الأوزان والهيكل التنظيميّ، تستقبل الشبكتان الفرعيتان إدخالين مختلفين وتنتجان إخراجين مختلفين، يتمّ مقارنتهما لتحديد التشابه أو الاختلاف بينهما، تُستخدم الشبكات السياميّة عادة في مهامّ مثل التشابه والمطابقة في الصور أو النصوص. يأتي اسم “سيامي” من حقيقة أنّ الشبكتين الفرعيتين هما “توءمان” متصلان معًا) لتعلّم تمثيل حيث يتمّ تقدير تشابه الجمل بواسطة تشابه دالة جيب التمام للزّاوية بين التضمينات، و Li et al. (2020)، ولكن لا يقدّمون مزيدًا من التفاصيل حول نهجهم.

يشير الشكل إلى أنّ الأداء في مهامّ البحث والتصنيف يتحسن مع زيادة فترة التدريب، بينما يتدهور الأداء في مهمة تشابه الجمل. يشير المؤلفون إلى أنّ عمليّة التبييض (Whitening) هي عملية بديلة لتحسين مساحة التضمين (في سياق النص المعطى، تشير عمليّة التبييض (Whitening) إلى تحويل رياضيّ يُطبق على مساحة التضمين في النموذج لتحسين الأصغريّة، تعني الأصغريّة أنّ الخصائص المقاسة ثابتة بغضّ النظر عن اتجاه القياس، وهو أمر مرغوب فيه في العديد من تطبيقات تعلم الآبة. تحوّل عمليّة التبييض مساحة التضمين لتكون لديها مصفوفة تباين متجانسة، وهذا يعني أنّ تباين كلّ بُعد يساوي واحد وأنّ التباين بين الأبعاد المختلفة يكون صفر. يمكن أن يحسّن هذا التحويل أداء النماذج التي تعتمد على مساحة التضمين، مثل تلك المستخدمة في مهامّ معالجة اللغة الطبيعيّة.)، كما ناقشه Su وآخرون (2021). كما يشيرون إلى أنه من المعتاد تهيئة النماذج باستخدام نموذج لغويّ مدرّب مسبقًا، كما ناقشه Devlin وآخرون (2019)، قبل التدريب على مجموعات بيانات استنتاج اللغة الطبيعيّة (NLI). الأصغريّة (Isotropy) هي مصطلح يُستخدم في الرّياضيات والفيزياء لوصف خاصية الثبات بغض النظر عن اتجاه القياس، بمعنى آخر النظام أو الفضاء الأصغريّ (Isotropic) يبدو متماثلًا في جميع الاتجاهات. في تعلّم الآلة الأصغريّة هي خاصية مرغوبة لمساحات التضمين (Embedding Spaces)، التي تُستخدم لتمثيل البيانات في مساحة ذات أبعاد أقل، تضمن مساحة التضمين الأصغرية أنّ المسافة بين أيّ نقطتين في المساحة لا تعتمد على اتجاه القياس، وهذا يمكن أن يحسّن أداء النماذج التي تعتمد على مساحة التضمين، مثل تلك المستخدمة في مهامّ معالجة اللغة الطبيعيّة NLP.

يذكر النصّ المعطى أنه تمّ دراسة عدّة أساليب لتعلّم تضمين الجمل بدون إشراف أو بإشراف ذاتيّ، تشمل بعض النهج الشائعة النظر إلى الجمل ضمن نفس السياق كعينات ذات معنى مماثل، وهذا يعني أنّ الجمل التي تشترك في سياقات مشابهة يتمّ التعامل معها على أنها متشابهة من حيث المعنى، وقد تمّ استكشاف عمليّات تكبير النصّ المختلفة لإنشاء أزواج تدريب إيجابيّة باستخدام عينات مكبَّرة، وتشمل تشويه القاموس (lexiconbased distortion)، استبدال المرادفات (synonym replacement)، الترجمة العكسيّة (back-translation)، القطع (cut-off)، والإسقاط (dropout) ومع ذلك، يُشير إلى أنّ نماذج تضمين الجمل بدون إشراف لا تزال تؤدّي بشكل ملحوظ أسوأ من الأساليب التي تعتمد على إشراف. وفقًا للنصّ المعطى، يشير البحث النصيّ على نطاق واسع باستخدام التضمينات الكثيفة واسترجاع المعلومات العصبيّة (Neural IR)، يشير إلى إمكانيّة التعميم بشكل أفضل من مطابقة الكلمات المفتاحيّة في نظم استرجاع المعلومات الكلاسيكيّة (IR). يشير ذلك إلى أنّ استخدام التضمينات الكثيفة وتقنيات استرجاع المعلومات العصبيّة، يمكن أن يحسّن أداء وفعاليّة البحث عن النصوص مقارنةً بالنهج التقليديّ القائم على الكلمات المفتاحيّة. من خلال تشفير المستندات باستخدام التضمينات الكثيفة واستخدام نماذج استرجاع المعلومات العصبية، يمكن أن تكون عمليّة البحث أكثر دقة وكفاءة، مما يؤدّي إلى تحسين التعميم في معالجة مهام البحث عن النصوص على نطاق واسع.

يذكر النص المعطى أنّ أنظمة استرجاع المعلومات العصبيّة (Neural IR)، يتمّ تشفير المستندات في مرحلة الفهرسة ومن ثمّ إجراء عمليّة البحث بالجيران الأقربين في وقت الاستعلام. غالبًا ما يتمّ تعلّم نماذج الاسترجاع العصبيّة من خلال ضبط نموذج لغويّ مدرّب مسبقًا على مجموعة مراقبة مشرفة للبحث، تجمع العديد من نماذج البحث الحديثة بين الاسترجاع الكلاسيكيّ واسترجاع المعلومات العصبيّة في إعداد مرحليّ، حيث يتمّ تضييق نطاق المرشحين في البداية بواسطة بحث الكلمات المفتاحيّة BM25 ثمّ إعادة ترتيبهم بواسطة تشفير الاستعلام المشترك والمستندات العصبيّة. يشير النصّ أيضًا إلى أنّ Xiong et al. (2020) قد اقترحوا ANCE، وهو إطار تعلّم تباينيّ لتعلّم تمثيلات النصّ للاسترجاع الكثيف باستخدام سلبيات صعبة تمّ استخراجها. يذكر النصّ المعطى أنّ أنظمة استرجاع المعلومات العصبيّة (Neural IR) يتمّ تشفير المستندات في مرحلة الفهرسة، ومن ثمّ إجراء عمليّة البحث بالجيران الأقربين في وقت الاستعلام.

غالبًا ما يتمّ تعلّم نماذج الاسترجاع العصبيّة من خلال ضبط نموذج لغويّ مدرّب مسبقًا على مجموعة مراقبة مشرفة للبحث. تستخدم طرق استرجاع غير الخاضعة للإشراق في مهام اخرى الـ “Inverse Cloze” أو الأقسام الملفوفة المُقنعة لتحقيق تحسينات كبيرة في مهام الإجابة على الأسئلة في النطاق المفتوح (ODQA). وقد أظهرت هذه الطرق، كما ذكرها Sachan et al. (2021)، نتائج واعدة في تعزيز أداء الاسترجاع بدون الحاجة إلى بيانات مشرفة. يشير النص أيضًا إلى أنه باستخدام دُفعة كبيرة بما فيه الكفاية، من الممكن تحقيق أداء بحث جيد بدون الاعتماد على البيانات المشرفة. يشرح النص المعطى أن البحث الدلالي عن الشّيفرة البرمجيّة هو مهمة استرجاع الشّيفرة البرمجيّة ذات الصلة بالاستعلام باللغة الطبيعية. وهناك تحدي (CodeSearchNet) كما ذكره Husain et al. (2020) يقدم مجموعة من مهام بحث الشّيفرة البرمجيّة القياسية في لغات البرمجة المختلفة.

يوفر التحدي أيضًا نموذجًا أساسيًا بسيطًا لتوقع التضمينات (embeddings) للاستعلام والشّيفرة البرمجيّة من خلال التّعلّم التبايني على مجموعة بيانات يتكون من أزواج (نص، شّيفرة البرمجيّة). يُستخدم هذا المجموعة لتدريب النماذج لمهام بحث الشّيفرة البرمجيّة وتقييم أدائها. الفروق بين ContraCode وCodeBERT وGraphCodeBERT من حيث نهجهم في تعلّم تضمينات النص والشّيفرة البرمجيّة هي كالتالي:

1. ContraCode

يستخدم ContraCode مهمة تعلّم التباين لتحديد البرامج المماثلة وظيفياً التي تم إنشاؤها من خلال تحويلات المترجم من لغة برمجه إلى لغة برمجه اخرى. بمعنى آخر، يحاول ContraCode التعرف على التشابه بين البرامج المعادلة والتي تم إنشاؤها بواسطة تحويلات مماثلة مع الحفاظ على الوظائف المتماثلة.

2. CodeBERT

يقوم CodeBERT بتعلُّم التشابه الدلالي باستخدام نموذج لغوي مُعدّ مسبقًا. عادةً ما يتم تدريب هذه النماذج على مجموعات بيانات كبيرة من رموز المصدر، ويمكن استخدامها كتضمينات للشفرة. من خلال هذا النهج، يحاول CodeBERT إنشاء تضمينات للبرامج تكون ممثلة للدلالة الخاصة بها، وتمكين مقارنة وتوقع التشابه بينها.

3. GraphCodeBERT

يقوم GraphCodeBERT بتحسين أدائه على مقياس CodeSearchNet عن طريق إضافة مهام مسبقة التدريب على هيكل الشّيفرة البرمجيّة. بدلاً من التركيز فقط على معنى الشّيفرة البرمجيّة كما هو الحال في CodeBERT، يستفيد GraphCodeBERT من معلومات الهيكل الشفري، مثل الرسومات البيانية للتبعية وهياكل الشّيفرة البرمجيّة، لتحقيق تحسينات في الأداء.

5. التأثير على النطاق الشامل

التحيزات المُشَفرة في نماذج التضمين يمكن أن تسبب “أضرار تمثيلية” عن طريق تعزيز التحيزات المجتمعية القائمة في مجموعة النصوص ونشرها في المهام اللاحقة لنماذج التضمين. بعبارة أخرى، يمكن أن تستمر هذه التحيزات وتعزز المواقف والسلوكيات التمييزية تجاه فئات معينة من الأشخاص مثل الأشخاص السود أو النساء، مما يؤدي إلى معاملة غير عادلة أو فرص ضائعة.

يشجع النص على مزيد من البحث حول أجندتين بحثيتين: (أ) تطوير منهجيات تقييم قوية لفئات متعددة من التحيز في بيانات التدريب والنماذج المدربة مسبقًا، و (ب) تطوير وتحسين طرق التخفيف من التحيز المُشفّر، بما في ذلك الضبط الدقيق لتقليل التحيز في النماذج المدربة مسبقًا. يشير النص إلى أنه حتى يكون لدينا منهجية تقييم قوية، من المهم تقييد ومراقبة استخدام النموذج في التطبيقات النهائية، لا سيما تلك التي يكون فيها خطر الضرر التمثيلي كبيرًا وتلك التي قد تؤثر فيها التمثيلات المتحيزة على تخصيص الموارد والفرص للناس. بعبارة أخرى، إلى أن نحصل على طرق أفضل لتحديد وتخفيف التحيزات في نماذج التضمين، من المهم توخي الحذر بشأن كيفية استخدام هذه النماذج في تطبيقات العالم الحقيقي، لا سيما في المواقف التي قد تكون فيها عواقب التمثيلات المتحيزة ضارة أو غير عادلة. عندما يتعلق الأمر بتدريب نماذج التضمين باستخدام دُفعات كبيرة، فإن ذلك يتطلب موارد حوسبة كبيرة ويكلف بيئيًا وحوسبيًا. ومع ذلك، هناك طرق واعدة لتوزيع وتعويض هذه التكاليف مع السماح للمستخدمين بالاستفادة من قدرات هذه النماذج. يشير النص إلى أن بعض الحلول المحتملة لهذه التكاليف تشمل الوصول العام الآمن إلى نماذج اللغة المدرّبة مسبقًا الكبيرة، ومسارات التدريب الفعالة التي تستغل هياكل النماذج المُحسّنة وأنظمة التدريب. يشجع النص على مزيد من البحث والجهود التنفيذية في هذه المجالات.

6. الخلاصة

حققت النّماذج نتائج جديدة على أعلى مستوى في مهام التّصنيف الخطي، البحث في النصوص، والبحث في الشّيفرة البرمجيّة. ومع ذلك، فقد تم تحقيق أداء ضعيف في مهام تشابه الجّمل وأظهرت النماذج سلوكًا غير متوقع في التدريب فيما يتعلق بهذه المهام.

7. ملحق خاص بالجداول

ترجمة جميع الاختصارت والعبارات8. المشار اليها في الجداول (1-9)

| الرّمز المختصر والعبارة الدّلاليّة | رقم الجدول | المعنى |

| Embed Dimensions | الجدول 1 | تشير “أبعاد التّضمين” بشكل نموذجيّ إلى عدد الأبعاد في مساحة المتّجهات المستخدمة لتمثيل الكلمات أو الجمل كتضمينات |

| Batch size | الجدول 1 | حجم الدفعة (عدد أمثلة التّدريب الّتي تتمّ معالجتها معًا في كلّ تكرار لعمليّة التّدريب.) |

| MR | الجدول 2 | مجموعة من البيانات تستخدم لتقييم النّموذج في تحليل المشاعر |

| CR | الجدول 2 | وهي مجموعة بيانات معياريّة لتقييم النّماذج في مهمّة تصنيف النّصّ |

| SUBJ | الجدول 2 | وهي مجموعة بيانات معياريّة لتقييم النّماذج المتعلّقة بمهمة التّصنيف الذاتيّ، وتحديد ما إذا كانت جملة معيّنة تعبر عن وجهة نظر ذاتيّة أو موضوعيّة |

| MPQA | الجدول 2 | وهي مجموعة بيانات معياريّة لتقييم النّماذج المتعلّقة بمهمّة قطبيّة الرّأي والتصنيف الذاتيّ، وتحديد قطبيّة وذاتيّة الآراء المعبر عنها في المقالات الإخباريّة |

| SST | الجدول 2 | وهي مجموعة بيانات معياريّة لتقييم النّماذج في مهمّة تصنيف المشاعر، وتحديدًا تصنيف المشاعر الثّنائيّة لمراجعات الأفلام |

| TREC | الجدول 2 | مجموعة بيانات معياريّة لتقييم النّماذج في مهمّة تصنيف الأسئلة، وتحديدًا تصنيف الأسئلة في مجموعة من الفئات المحددّة مسبقًا |

| MRPC | الجدول 2 | وهي مجموعة بيانات معياريّة لتقييم النّماذج في مهمّة تحديد إعادة الصّياغة، وتحديد ما إذا كانت جملتان متكافئتان لغويًّا |

| Avg. | الجدول 2 | متوسط أداء النموذج عبر مجموعة البيانات الساّبقة |

| BERTBidirectional Encoder Representations from Transformers | الجدول 2 | يرمز إلى تمثيلات التّشفير ثنائيّة الاتّجاه وهو نوع من نماذج اللّغة المدرّبة مسبقًا المستخدمة في مهام معالجة اللّغة الطبيعيّة مثل الإجابة على الأسئلة وتحليل المشاعر |

| SimCSESimple Contrastive Learning of Sentence | الجدول 2&4 | التّعلّم التبايني البسيط للجملة وهي طريقة لتدريب النّماذج على تمثيل الجمل كمتّجهات |

| DECLUTR | الجدول 2 | أسلوب لتدريب النّماذج على تمثيل النّصوص على شكل متّجهات بطريقة غير خاضعة للإشراف |

| cpt-text SContrastive pre training text | الجدول 2 | التّدريب التّباينيّ الأوّليّ للنّصوص باستخدام مجموعات صغيرة |

| cpt-text MContrastive pre training text | الجدول 2 | التّدريب التّباينيّ الأوّليّ للنّصوص باستخدام مجموعات متوسطة |

| cpt-text LContrastive pre training text | الجدول 2 | التّدريب التّباينيّ الأوّليّ للنّصوص باستخدام مجموعات كبيرة |

| cpt-text XLContrastive pre training text | الجدول 2 | التّدريب التّباينيّ الأوّليّ للنّصوص باستخدام مجموعات كبيرة جدّاً |

| Transfer from NLI data | الجدول 2 | الاستدلال اللغويّ الطبيعيّ |

| SBERTSentence-BERT | الجدول 2 | هي طريقة لتدريب النّماذج على تمثيل الجمل كمتّجهات باستخدام معماريّات شبكات ثنائيّة وثلاثيّة. |

| SimCSE | الجدول 2 | يشير إلى طريقة محدّدة تسمى “التّعلّم التّبايني البسيط لتضمينات الجمل” ، وهي طريقة بسيطة وفعّالة لتعلّم عمليّات دمج الجمل باستخدام التّعلّم . |

| Unsupervised | الجدول 2 | التّعلّم غير الخاضع للإشراف |

| zero-shot | الجدول 3 | “طلقة صفريّة” يأتي هذا المصطلح من حقيقة أنّ النّموذج قادر على أداء جيّد بشكل معقول في المهمّة الجديدة دون أيّ تدريب أو إشراف صريح |

| zero-shot with prompting | الجدول 3 | يشير مصطلح “لقطة صفريّة مع المطالبة” إلى نوع من نقل التّعلّم حيث يتمّ تدريب النّموذج على مهمّة واحدة ثمّ يتمّ تطبيقه على مهمّة مختلفة دون أيّ ضبط دقيق أو تدريب إضافيّ على المهمّة المستهدفة، ولكن مع إضافة وصف موجّه أو تسمية لتوجيه تنبؤات النّموذج الموجّه عبارة عن وصف بسيط للتسمية، مثل “هذا مثال على مراجعة فيلم إيجابيّة / سلبيّة” ، يتم توفيرها للنّموذج جنبًا إلى جنب مع نص الإدخال للمهمّة الجديدة. |

| k-NN | الجدول 3 | هو نوع من التّعلّم القائم على المثيل أو المشابه، حيث لا يتعلّم النّموذج صراحةً وظيفة لتعيين المدخلات إلى المخرجات، ولكن بدلاً من ذلك يخزّن بيانات التّدريب ويستخدمها لعمل تنبّؤات بناءً على التشابه مع الأمثلة السابقة. |

| Linear-probe | الجدول 3 | هو أسلوب يستخدم التّضمينات المدرّبة مسبقًا لحل مهمّة جديدة. يتمّ تعلّم التّضمينات عن طريق تدريب نموذج للتنبّؤ بالكلمة التّالية في جملة، دون وجود مهمّة محددّة في الاعتبار. ثم يتمّ تدريب مصنّف خطّيّ على التّضمينات لحلّ مهمّة جديدة، مثل تصنيف المشاعر أو الاستدلال اللّغويّ الطّبيعيّمن خلال ضبط التّضمينات المدرّبة مسبقًا على المهمّة الجديدة، يمكن لطريقة الـ “linear-probe” تحقيق نتائج متقدمة في النّماذج الأكبر حجماّ |

| Full fine-tuned SOTA | الجدول 3 | يشير إلى طريقة التصنيف حيث يتم ضبط نموذج اللغة المدرب مسبقًا على مهمة محددة باستخدام التّعلّم الإشرافي. يتم تدريب نموذج اللغة على مجموعة بيانات تحتوي على تسميات للمهمة المحددة، مثل تصنيف المشاعر أو الاستدلال اللغوي الطبيعي، بهدف تحسين معلمات النموذج لتقليل الخطأ في التنبؤ بالمهمة. “SOTA” في “Full fine-tuned SOTA” يعني “الحالة الأفضل”، مما يعني أن هذه الطريقة تحقق أفضل أداء في المهمة المحددة بين جميع الطرق التي تم التحدث عنها في هذه المقالة |

| STS”Semantic Textual Similarity | الجدول 4 | هي معيار مقاييس لتقييم جودة تضمين الجمل، حيث يتطلب من التضمينات أن تمتلك قدرة على التقاط معنى الجمل وتشابهها بطريقة ذات مغزى |

| MSMARCO” “Microsoft MAchine Reading Comprehension | الجدول 5 | تشير إلى فهم القراءة من Microsoft MAChine”. وهي مجموعة بيانات واسعة النطاق لفهم القراءة الآلية، والتي تتكون من أكثر من مليون سؤال والمقاطع المقابلة لها. |

| NQNatural Questions | الجدول 5 | مجموعة بيانات واسعة النطاق للإجابة على الأسئلة، والتي تتكون من أكثر من 300000 سؤال وإجاباتهم الطويلة المقابلة من ويكيبيديا. |

| TriviaQA | الجدول 5 | عبارة عن مجموعة بيانات واسعة النطاق للإجابة على الأسئلة، والتي تتكون من أكثر من 650 ألف سؤال والإجابات المقابلة لها من مصادر مختلفة، بما في ذلك صفحات الويب والكتب وويكيبيديا |

| Covidcoronavirus disease”” | الجدول 6 | تعني “مرض فيروس كورونا”، وهو مرض معد يسببه فيروس SARS-CoV-2 |

| Nfc”Near Field Communication | الجدول 6 | وهي تقنية تسمح لجهازين بالتواصل مع بعضهما البعض عندما يكونان على مقربة من بعضهما البعض، عادةً في حدود بضعة سنتيمترات. |

| FiqaFact-based Image Question Answering | الجدول 6 | تعنى إجابة أسئلة الصور القائمة على الحقائق وهي مهمة تتضمن الإجابة على أسئلة حول صورة ما بناءً على معلومات واقعية |

| Quora | الجدول 6 | وهي عبارة عن منصة أسئلة وأجوبة حيث يمكن للمستخدمين طرح الأسئلة والإجابة عليها حول مجموعة واسعة من الموضوعات. |

| climate | الجدول 6 | يشير مصطلح “المناخ” إلى موضوع تغير المناخ، وهو التغيير طويل الأمد لأنماط الطقس العالمية ومتوسط درجات الحرارة |

| dbp | الجدول 6 | وهو عبارة عن جهد يحركه المجتمع لاستخراج المعلومات المنظمة من ويكيبيديا وإتاحتها على الويب كبيانات مرتبطة |

| hotpot“ | الجدول 6 | وهي مجموعة بيانات واسعة النطاق للإجابة على الأسئلة تركز على التفكير المعقد عبر مستندات متعددة. |

| fever | الجدول 6 | يشير إلى مجموعة بيانات استخراج الحقائق والتحقق، وهي مجموعة بيانات معيارية لمهام التحقق من صحة الأخبار والتحقق منها |

| BM25Best Matching 25 algorithm | الجدول 6 | ويتم استخدام BM25 كطريقة أساسية لتقييم أداء النماذج المختلفة في مهام استرجاع المعلومات المختلفة. |

| Contriever | الجدول 6 | يعتمد هذا النموذج على فكرة استخدام دالة الخسارة التباينية لمعرفة تمثيلات النص التي تم تحسينها لمهام الاسترجاع. على وجه التحديد، يتم تدريب النموذج على زيادة التشابه بين أزواج النص ذات الصلة وتقليل التشابه بين أزواج النص غير الملائمة |

| TAS-B (Hofst¨atter et al., 2021) | الجدول 6 | يشير إلى نموذج تم اقتراحه بواسطة Hofstätter et al. (2021) لتعلّم النقل في إجابة الأسئلة في المجال المفتوح. يستند نموذج TAS-B إلى فكرة تهذيب نموذج لغة مدرب مسبقًا على كمية صغيرة من البيانات المحددة للمهمة، وتمت إظهار قدرته على تحقيق أداء متقدم على العديد من مجموعات البيانات القياسية في مهام إجابة الأسئلة في المجال المفتوح والتحقق من الحقائق. يتم استخدام نموذج TAS-B كطريقة أساسية لتقييم أداء نماذج مختلفة في مهام استرجاع المعلومات المختلفة، ويتم مقارنته مع طرق أخرى خاضعه للإشراف وغير خاضعه للإشراف |

| docT5query | الجدول 6 | يشير إلى نموذج اقترحه بواسطة Nogueira et al. (2019a) للإجابة على أسئلة المجال المفتوح ومهام التحقق من الحقائق. لقد ثبت أن نموذج استعلام docT5 يحقق أداءً تنافسيًا في العديد من مجموعات البيانات المعيارية للإجابة على أسئلة المجال المفتوح ومهام التحقق من الحقائق، وقد تم استخدامه كطريقة أساسية لتقييم أداء النماذج الأخرى التي تم ذكرها في المقالة. |

| ANCE”Approximate Nearest neigbor Contrastive lEarning” | الجدول 6 | هو إطار تعليمي متباين لتعلّم تمثيلات النص للاسترجاع الكثيف باستخدام السلبيات. يتم تدريب النموذج باستخدام وظيفة الخسارة المتناقضة التي تشجع أزواج النص المتشابهة على أن تكون أقرب معًا في مساحة التضمين، بينما يتم دفع الأزواج غير المتشابهة عن بعضها بشكل أكبر |

| BM25 + CE | الجدول 6 | يشير إلى نموذج اقترحه Wang et al. (2020) للاسترجاع الكثيف باستخدام مزيج من البحث المستند إلى الكلمات الرئيسية وإعادة التصنيف القائمة على الشبكة العصبية. يعتمد نموذج BM25 + CE على فكرة استخدام BM25، وهي طريقة بحث شائعة تعتمد على الكلمات الرئيسية (Robertson، 2009) ، لتحديد أفضل 100 وثيقة من المرجح أن تحتوي على معلومات ذات صلة لاستعلام معين. |

| ColBERT v2 | الجدول 6 | هي طريقة لتمثيل الاستعلامات والنصوص على شكل متجهات ويتميز بوجود تحسينات عليه مثل إجراءات التدريب المحسّنة وتقنيات الفهرسة الأكثر كفاءة |

| Splade v2 | الجدول 6 | إنها طريقة لاسترجاع المعلومات تستخدم نموذجًا معجميًا متفرقًا لتمثيل الاستعلامات والمستندات، ونموذج التوسيع لإنشاء مصطلحات إضافية ذات صلة بالاستعلام |

| CodeBERT | الجدول 7 | هو نموذج لغة تم تدريبه مسبقًا وهو مصمم خصيصًا للغات البرمجة. يعتمد على بنية المحولات ويتم تدريبه على مجموعة كبيرة من التعليمات البرمجية ونصوص اللغات الطبيعية لتعلّم التمثيل المشترك للاكود واللغات الطبيعيه |

| GraphCodeBER | الجدول 7 | يتضمن مهام ما قبل التدريب التي تتضمن التنبؤ بهيكل الكود، مثل التنبؤ بنوع المتغير أو تدفق التحكم في البرنامج. يتم تدريب النموذج على مجموعة كبيرة من التعليمات البرمجية ونص اللغة الطبيعية لتعلّم التمثيل المشترك للكود واللغة الطبيعية، بالإضافة إلى المعلومات الهيكلية للكود. |

| MRR @ 10 | الجدول 9 | تعني “متوسط الترتيب المتبادل عند 10 وهو مقياس يستخدم لتقييم أداء أنظمة استرجاع المعلومات مثل محركات البحث. يقيس المقياس فعالية النظام في ترتيب المستندات ذات الصلة استجابةً للاستعلام. تقوم MRR @ 10 بحساب متوسط الرتب المتبادلة لأعلى 10 مستندات مستردة لمجموعة من الاستعلامات. الترتيب المتبادل هو معكوس رتبة الوثيقة الأولى ذات الصلة في قائمة الوثائق المسترجعة. تشير درجة MRR @ 10 الأعلى إلى أداء أفضل، لأنها تعني أن المستندات ذات الصلة مرتبة أعلى في المتوسط. |

شرح بعض المصطلحات التي تم ذكرها في المقالة

1.9. التّدريب التبايني المسبق Contrastive Pre-Training

هو عمليّة تدريب تستخدم في تعلّم النّماذج الذّكيّة وتضمين النّصوص Text Embedding، يهدف هذا النّوع من التّدريب إلى توليد تمثيلات عالية الجودة للنّصوص بناءً على التّباين (التّناقض) بين النّصوص المختلفة، يتمّ ذلك من خلال تدريب النّموذج على مهمّة التّمييز بين الأزواج المتناقضة من النّصوص، حيث يتعلّم النّموذج كيفيّة تمثيل وفصل النّصوص المتناقضة بشكل فعّال. عند تدريب النّموذج يتمّ تزويده بأزواج من النّصوص المتناقضة؛ مثل جملتين تعبّر عن رأيين متضادّين. يتعلّم النّموذج تجاوز الاختلافات اللّغويّة والنّحويّة والموضوعيّة بين هذه النّصوص والتّركيز على العناصر الأساسيّة التي تجعلها متناقضة، هذا يساعد النّموذج على فهم العلاقات الدّلاليّة والتّشابه والاختلاف بين النّصوص. وبفضل التّدريب التبايني المسبق، يتمّ إنشاء تضمينات (مشفّرات) نصوص ذات جودة عالية تمثّل معاني النّصوص وتعبّر عنها بشكل فعّال، يمكن استخدام هذه التّضمينات في مجموعة متنوّعة من التّطبيقات؛ مثل البحث الدّلالي وتحليل التّشابه بين النّصوص والتّصنيف النّصّيّ والتّرجمة الآليّة، وتساهم في تحسين أداء النّماذج الذّكيّة في هذه المهام.

2.9. خوارزميّة الجيران الأقرب K-Nearest Neighbors

k-NN هو اختصار لـ “k-Nearest Neighbors”، وهي خوارزمية تصنيف تستخدم في تعلّم الآلة تعتمد على مبدأ الأقرب فالأقرب، حيث يتمّ تصنيف نقطة جديدة بناءً على الأشياء المماثلة الأقرب إليها في مجموعة البيانات المتاحة، تعمل الخوارزميّة على تقسيم البيانات إلى فئات مختلفة بناءً على قيم السمات المشتركة، عندما يتمّ تقديم نقطة جديدة للتصنيف؛ يتمّ حساب المسافة بين هذه النقطة وجميع النقاط الموجودة في مجموعة البيانات، ثمّ يتمّ اختيار النقاط الأقرب إليها بناءً على قيمة k (عدد الجيران المحدّدة مسبقًا). يتمّ تصنيف النقطة الجديدة بناءً على الغالبيّة في فئات الجيران الأقرب، في هذا القسم نناقش النتائج باستخدام التصنيف الصفريّ (Zero-shot classification) وتصنيف الجيران الأقرب k-Nearest Neighbor على مهمة تصنيف المشاعر الثنائيّة SST-2 (Socher et al., 2013).

3.9. التأثير على النطاق الشامل

بمعنى اخر عندما تقوم نماذج تمثيل النص بترميز التحيزات الموجودة في بيانات التدريب الخاصة بهم، فقد تعمل على إدامة المواقف والسلوكيات التمييزية وتضخيمها تجاه مجموعات معينة من الناس، مثل السود أو النساء. هذا يمكن أن يؤدي إلى معاملة غير عادلة أو فرص ضائعة لهذه المجموعات. على سبيل المثال، إذا تم تدريب نموذج التضمين على بيانات نصية تحتوي على لغة متحيزة أو صور نمطية عن النساء، فقد يتعلّم النموذج ربط كلمات أو مفاهيم معينة بالنساء بطريقة سلبية. قد يؤدي ذلك إلى تطبيقات نهائية للنموذج، مثل أنظمة التوظيف المؤتمتة، التي تميز بشكل غير عادل ضد المرأة. وبالمثل، إذا تم تدريب نموذج التضمين على بيانات نصية تحتوي على لغة متحيزة أو صور نمطية عن السود، فقد يتعلّم النموذج ربط كلمات أو مفاهيم معينة بالأشخاص السود بطريقة سلبية. قد يؤدي ذلك إلى تطبيقات المصب للنموذج، مثل أنظمة تقييم المخاطر الآلية، التي تستهدف أو تعاقب السود بشكل غير عادل

10. المراجع

- Text and Code Embeddings by Contrastive Pre-Training

- Bengio, Y., Courville, A. C., and Vincent, P. Representation learning: A review and new perspectives. Transactions on pattern analysis and machine intelligence, 35 (8), 2012.

- Bolukbasi, T., Chang, K., Zou, J. Y., Saligrama, V., and Kalai, A. Man is to computer programmer as woman is to homemaker? debiasing word embeddings. 29, 2016.

- Bowman, S. R., Angeli, G., Potts, C., and Manning, C. D. A large annotated corpus for learning natural language inference. In Conference on Empirical Methods in Natural Language Processing (EMNLP). ACL, 2015.

- Brown, P. F., Della Pietra, V. J., deSouza, P. V., Lai, J. C., and Mercer, R. L. Class-based n-gram models of natural language. Computational Linguistics, 18(4):467–480, 1992.

- Brown, T., Mann, B., Ryder, N., Subbiah, M., Kaplan, J. D., Dhariwal, P., Neelakantan, A., Shyam, P., Sastry, G., Askell, A., Agarwal, S., Herbert-Voss, A., Krueger, G., Henighan, T., Child, R., Ramesh, A., Ziegler, D., Wu, J., Winter, C., Hesse, C., Chen, M., Sigler, E., Litwin, M., Gray, S., Chess, B., Clark, J., Berner, C., McCandlish, S., Radford, A., Sutskever, I., and Amodei, D. Language models are few-shot learners. In Advances in Neural Information Processing Systems, 2020.

- Caliskan, A., Bryson, J. J., and Narayanan, A. Semantics derived automatically from language corpora contain human-like biases. Science, 356(6334):183–186, 2017.

- Chen, M., Tworek, J., Jun, H., Yuan, Q., de Oliveira Pinto, H. P., Kaplan, J., Edwards, H., Burda, Y., Joseph, N., Brockman, G., Ray, A., Puri, R., Krueger, G., Petrov, M., Khlaaf, H., Sastry, G., Mishkin, P., Chan, B., Gray, S., Ryder, N., Pavlov, M., Power, A., Kaiser, L., Bavarian, M., Winter, C., Tillet, P., Such, F. P., Cummings, D., Plappert, M., Chantzis, F., Barnes, E., Herbert-Voss, A., Guss, W. H., Nichol, A., Paino, A., Tezak, N., Tang, J., Babuschkin, I., Balaji, S., Jain, S., Saunders, W., Hesse, C., Carr, A. N., Leike, J., Achiam, J., Misra, V., Morikawa, E., Radford, A., Knight, M., Brundage, M., Murati, M., Mayer, K., Welinder, P., McGrew, B., Amodei, D., McCandlish, S., Sutskever, I., and Zaremba, W. Evaluating large language models trained on code. arXiv preprint arXiv:2107.03374, 2021.

- Chen, T., Kornblith, S., Norouzi, M., and Hinton, G. E. A simple framework for contrastive learning of visual representations. In International conference on machine learning (ICML), 2020.

- Chopra, S., Hadsell, R., and LeCun, Y. Learning a similarity metric discriminatively, with application to face verification. In Computer Vision and Pattern Recognition (CVPR). IEEE, 2005.

- Conneau, A. and Kiela, D. Senteval: An evaluation toolkit for universal sentence representations. arXiv preprint arXiv:1803.05449, 2018.

- Crawford, K. The trouble with bias. Keynote at NeurIPS, 2017.

- Deerwester, S., Dumais, S., Furnas, G., Landauer, T., and Harshman, R. Indexing by latent semantic analysis. Journal of the American society for information science, 41(6):391–407, 1990.

- Devlin, J., Chang, M.-W., Lee, K., and Toutanova, K. BERT: Pre-training of deep bidirectional transformers for language understanding. In Conference of the North American Chapter of the Association for Computational Linguistics (NAACL). ACL, 2019.

- Fang, H. and Xie, P. CERT: contrastive self-supervised learning for language understanding. arXiv preprint arXiv:2005.12766, 2020.

- Feng, Z., Guo, D., Tang, D., Duan, N., Feng, X., Gong, M., Shou, L., Qin, B., Liu, T., Jiang, D., and Zhou, M. Codebert: A pre-trained model for programming and natural

- Gao, T., Yao, X., and Chen, D. SimCSE: Simple contrastive learning of sentence embeddings. In Conference on Empirical Methods in Natural Language Processing (EMNLP), 2021.

- Giorgi, J. M., Nitski, O., Bader, G. D., and Wang, B. Declutr: Deep contrastive learning for unsupervised textual representations. In Proceedings of ACL/IJCNLP, 2020.

- Goodman, N. Seven strictures on similarity. Bobbs Merrill, 1972.

- Rudinger, R., Naradowsky, J., Leonard, B., and Durme, B. V. Gender bias in coreference resolution. arXiv preprint arXiv:1804.09301, 2018.

- Sachan, D. S., Patwary, M., Shoeybi, M., Kant, N., Ping, W., Hamilton, W. L., and Catanzaro, B. End-to-end training of neural retrievers for open-domain question answering. In Zong, C., Xia, F., Li, W., and Navigli, R. (eds.), Proceedings of ACL/IJCNLP, pp. 6648–6662. ACL, 2021.

- Santhanam, K., Khattab, O., Saad-Falcon, J., Potts, C., and Zaharia, M. Colbertv2: Effective and efficient retrieval via lightweight late interaction. arXiv preprint arXiv:2112.01488, 2021.

- Schroff, F., Kalenichenko, D., and Philbin, J. Facenet: A unified embedding for face recognition and clustering. In Computer Vision and Pattern Recognition (CVPR), 2015.

- Shen, D., Zheng, M., Shen, Y., Qu, Y., and Chen, W. A simple but tough-to-beat data augmentation approach for natural language understanding and generation. arXiv preprint arXiv:2009.13818, 2020.

- Socher, R., Perelygin, A., Wu, J., Chuang, J., Manning, C. D., Ng, A., and Potts, C. Recursive deep models for semantic compositionality over a sentiment treebank. In Conference on Empirical Methods in Natural Language Processing (EMNLP), 2013.

- Sohn, K. Improved deep metric learning with multi-class n-pair loss objective. In Advances in Neural Information Processing Systems (NeuriPS), 2016.

- Solaiman, I. and Dennison, C. Process for adapting language models to society (PALMS) with values-targeted datasets. arXiv preprint arXiv:2106.10328, 2021.

- Su, J., Cao, J., Liu, W., and Ou, Y. Whitening sentence representations for better semantics and faster retrieval. arXiv preprint arXiv:2103.15316, 2021.

- Sun, C., Myers, A., Vondrick, C., Murphy, K., and Schmid, C. Videobert: A joint model for video and language representation learning. In International Conference on Computer Vision (ICCV), 2019.

- Thakur, N., Reimers, N., R¨uckl´e, A., Srivastava, A., and Gurevych, I. BEIR: A heterogeneous benchmark for zero-shot evaluation of information retrieval models. In Advances in Neural Information Processing Systems (NeuriPS), 2021.

- Tian, Y., Krishnan, D., and Isola, P. Contrastive multiview coding. European Conference on Computer Vision (ECCV), 2019.

- van den Oord, A., Dieleman, S., Zen, H., Simonyan, K., Vinyals, O., Graves, A., Kalchbrenner, N., Senior, A., and Kavukcuoglu, K. Wavenet: A generative model for raw audio. arXiv preprint arXiv:1609.03499, 2016.

- van den Oord, A., Li, Y., and Vinyals, O. Representation learning with contrastive predictive coding. arXiv preprint arXiv:1807.03748, 2018.

- Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., Kaiser, L. u., and Polosukhin, I. Attention is all you need. In Advances in Neural Information Processing Systems (NeuriPS), 2017.

- Vervaeke, J., Lillicrap, T. P., and Richards, B. A. Relevance realization and the emerging framework in cognitive science. Journal of logic and computation, 22(1):79–99, 2012.

- Wang, W., Wei, F., Dong, L., Bao, H., Yang, N., and Zhou, M. Minilm: Deep self-attention distillation for task-agnostic compression of pre-trained transformers. arXiv preprint arXiv:2002.10957, 2020.

- Wei, J. W. and Zou, K. EDA: easy data augmentation techniques for boosting performance on text classification tasks. arXiv preprint arXiv:1901.11196, 2019.

- Williams, A., Nangia, N., and Bowman, S. A broad-coverage challenge corpus for sentence understanding through inference. In Conference of the North American Chapter of the Association for Computational Linguistics (NAACL). ACL, 2018.

- Wu, Z., Xiong, Y., Yu, S. X., and Lin, D. Unsupervised feature learning via non-parametric instance-level discrimination. In Computer Vision and Pattern Recognition (CVPR), 2018.

- Xiong, L., Xiong, C., Li, Y., Tang, K., Liu, J., Bennett, P. N., Ahmed, J., and Overwijk, A. Approximate nearest neighbor negative contrastive learning for dense text retrieval. arXiv preprint arXiv:2007.00808, 2020.

- Yih, W.-t., Toutanova, K., Platt, J. C., and Meek, C. Learning discriminative projections for text similarity measures. In Conference on Computational Natural Language Learning (CoNLL). ACL, 2011.

- Zbontar, J., Jing, L., Misra, I., LeCun, Y., and Deny, S. Barlow twins: Self-supervised learning via redundancy reduction. In International Conference on Machine Learning (ICML), 2021.

- Zhang, Y., He, R., Liu, Z., Lim, K. H., and Bing, L. An unsupervised sentence embedding method by mutual information maximization. In Conference on Empirical Methods in Natural Language Processing (EMNLP), 2020.

- Guo, D., Ren, S., Lu, S., Feng, Z., Tang, D., Liu, S., Zhou, L., Duan, N., Svyatkovskiy, A., Fu, S., Tufano, M., Deng, S. K., Clement, C. B., Drain, D., Sundaresan, N., Yin, J., Jiang, D., and Zhou, M. Graphcodebert: Pretraining code representations with data flow. In International Conference on Learning Representation (ICLR), 2021.

- Gutmann, M. and Hyv¨arinen, A. Noise-contrastive estimation: A new estimation principle for unnormalized statistical models. In Conference on Artificial Intelligence and Statistics. PMLR, 2010.

- Guu, K., Lee, K., Tung, Z., Pasupat, P., and Chang, M. REALM: retrieval-augmented language model pretraining. arXiv preprint arXiv:2002.08909, 2020.

- Hadsell, R., Chopra, S., and LeCun, Y. Dimensionality reduction by learning an invariant mapping. In Computer Vision and Pattern Recognition (CVPR), volume 2, pp. 1735–1742. IEEE, 2006.

- He, K., Fan, H., Wu, Y., Xie, S., and Girshick, R. B. Momentum contrast for unsupervised visual representation learning. In Computer Vision and Pattern Recognition (CVPR), 2020.

- Hofst¨atter, S., Lin, S., Yang, J., Lin, J., and Hanbury, A. Efficiently teaching an effective dense retriever with balanced topic aware sampling. arXiv preprint arXiv:2104.06967, 2021.

- Husain, H., Wu, H.-H., Gazit, T., Allamanis, M., and Brockschmidt, M. CodeSearchNet challenge: Evaluating the state of semantic code search. arXiv preprint arXiv:1909.09436, 2020.

- Izacard, G., Caron, M., Hosseini, L., Riedel, S., Bojanowski, P., Joulin, A., and Grave, E. Towards unsupervised dense information retrieval with contrastive learning. arXiv preprint arXiv:2112.09118, 2021.

- Jain, P., Jain, A., Zhang, T., Abbeel, P., Gonzalez, J. E., and Stoica, I. Contrastive code representation learning. In Conference on Empirical Methods in Natural Language Processing (EMNLP), 2021.

- Jia, C., Yang, Y., Xia, Y., Chen, Y.-T., Parekh, Z., Pham, H., Le, Q. V., Sung, Y., Li, Z., and Duerig, T. Scaling up visual and vision-language representation learning with noisy text supervision. In International Conference on Machine Learning (ICML), 2021.

- Johnson, J., Douze, M., and J´egou, H. Billion-scale similarity search with gpus. IEEE Transactions on Big Data, 2019.

- Kobayashi, S. Contextual augmentation: Data augmentation by words with paradigmatic relations. arXiv preprint arXiv:1805.06201, 2018.

- Kwiatkowski, T., Palomaki, J., Redfield, O., Collins, M., Parikh, A., Alberti, C., Epstein, D., Polosukhin, I., Kelcey, M., Devlin, J., Lee, K., Toutanova, K. N., Jones, L., Chang, M.-W., Dai, A., Uszkoreit, J., Le, Q., and Petrov, S. Natural questions: a benchmark for question answering research. Transactions of the Association of Computational Linguistics, 2019.

- Lee, K., Chang, M., and Toutanova, K. Latent retrieval for weakly supervised open domain question answering. In Korhonen, A., Traum, D. R., and M`arquez, L. (eds.), Conference of the Association for Computational Linguistics (ACL), pp. 6086–6096. ACL.

- Lewis, P. S. H., Perez, E., Piktus, A., Petroni, F., Karpukhin, V., Goyal, N., K¨uttler, H., Lewis, M., Yih, W., Rockt¨aschel, T., Riedel, S., and Kiela, D. Retrieval-augmented generation for knowledge-intensive NLP tasks. In Advances in Neural Information Processing Systems (NeuriPS), 2020.

- Li, B., Zhou, H., He, J., Wang, M., Yang, Y., and Li, L. On the sentence embeddings from pre-trained language models. In Conference on Empirical Methods in Natural Language Processing (EMNLP), 2020.

- Liang, P. P., Li, I. M., Zheng, E., Lim, Y. C., Salakhutdinov, R., and Morency, L. Towards debiasing sentence representations. In Conference of the Association for Computational Linguistics (ACL), 2020.

- Lin, J., Nogueira, R., and Yates, A. Pretrained transformers for text ranking: BERT and beyond. Synthesis Lectures on Human Language Technologies, 14(4):1–325, 2021.

- Logeswaran, L. and Lee, H. An efficient framework for learning sentence representations. In International Conference on Learning Representation (ICLR), 2018.

- Lu, J., Batra, D., Parikh, D., and Lee, S. Vilbert: Pretraining task-agnostic visiolinguistic representations for vision-and-language tasks. arXiv preprint arXiv:1908.02265, 2019.

- May, C., Wang, A., Bordia, S., Bowman, S. R., and Rudinger, R. On measuring social biases in sentence encoders. In Conference of the North American Chapter of the Association for Computational Linguistics (NAACL), 2019.

- Mikolov, T., Chen, K., Corrado, G. S., and Dean, J. Efficient estimation of word representations in vector space. arXiv preprint arXiv:1301.3781, 2013.

- Nguyen, T., Rosenberg, M., Song, X., Gao, J., Tiwary, S., Majumder, R., and Deng, L. MS MARCO: A human generated machine reading comprehension dataset. arXiv preprint arXiv:1611.09268, 2016.

- Nogueira, R., Lin, J., and Epistemic, A. From doc2query to doctttttquery. Online preprint, 2019.

- Nogueira, R., Yang, W., Cho, K., and Lin, J. Multistage document ranking with BERT. arXiv preprint arXiv:1910.14424, 2019.

- Park, J. H., Shin, J., and Fung, P. Reducing gender bias in abusive language detection. In Conference on Empirical Methods in Natural Language Processing (EMNLP), 2018.

- Pennington, J., Socher, R., and Manning, C. GloVe: Global vectors for word representation. In Conference on Empirical Methods in Natural Language Processing (EMNLP), 2014.

- Peters, M. E., Neumann, M., Iyyer, M., Gardner, M., Clark, C., Lee, K., and Zettlemoyer, L. Deep contextualized word representations. In Proceedings of NCAAL/IJCNLP, 2018.

- Qu, Y., Ding, Y., Liu, J., Liu, K., Ren, R., Zhao, X., Dong, D.,Wu, H., andWang, H. Rocketqa: An optimized training approach to dense passage retrieval for open-domain question answering. In Conference of the Association for Computational Linguistics (ACL), 2021.

- Radford, A., Kim, J.W., Hallacy, C., Ramesh, A., Goh, G., Agarwal, S., Sastry, G., Askell, A., Mishkin, P., Clark, J., Krueger, G., and Sutskever, I. Learning transferable visual models from natural language supervision. arXiv preprint arXiv:2103.00020, 2021.

- Raffel, C., Shazeer, N., Roberts, A., Lee, K., Narang, S., Matena, M., Zhou, Y., Li, W., and Liu, P. J. Exploring the limits of transfer learning with a unified text-to-text transformer. arXiv preprint arXiv:1910.10683, 2019.

- Ramesh, A., Pavlov, M., Goh, G., Gray, S., Voss, C., Radford, A., Chen, M., and Sutskever, I. Zero-shot text-to-image generation. arXiv preprint arXiv:2102.12092, 2021.

- Reimers, N. and Gurevych, I. Sentence-bert: Sentence embeddings using siamese bert-networks. In Conference on Empirical Methods in Natural Language Processing (EMNLP), 2019.

- Robertson, S. The Probabilistic Relevance Framework: BM25 and Beyond. Foundations and Trends® in Information Retrieval, 2009.

- Zhao, J., Wang, T., Yatskar, M., Ordonez, V., and Chang, K. Gender bias in coreference resolution: Evaluation and debiasing methods. arXiv preprint arXiv:1804.06876, 2018.